Cynthia Rudin. Kredit:Duke University

När modeorden "maskininlärning" fortsätter att växa i popularitet, fler industrier vänder sig till datoralgoritmer för att svara på viktiga frågor, inklusive höginsatsområden som sjukvård, ekonomi och straffrätt. Även om denna trend kan leda till stora förbättringar i dessa områden, det kan också leda till stora problem när maskininlärningsalgoritmen är en så kallad "black box".

En svart låda är ett maskininlärningsprogram som inte förklarar hur det når sina slutsatser, antingen för att det är för komplicerat för en människa att förstå eller för att dess inre funktioner är proprietära. Som svar på farhågor om att dessa typer av modeller kan innehålla orättvisa inre handlingar – som rasism – är en annan växande trend att skapa ytterligare modeller för att "förklara" dessa svarta lådor.

I en ny ledare publicerad i Nature Machine Intelligence , Cynthia Rudin, docent i datavetenskap, el- och datateknik, matematik, och statistisk vetenskap vid Duke University, hävdar att black box-modeller måste överges för beslut med hög insats. Även när så kallade förklaringsmodeller skapas, hon säger, beslutsfattare bör välja tolkningsbara modeller, som är helt transparenta och lätta att förstå för användarna.

Förklarliga modeller är fel

"Förklarliga" maskininlärningsmodeller är byggda i ett försök att förstå vad som händer inuti en svart låda. Om det kan ge samma resultat, folk antar att det är en korrekt representation.

Men det är inte.

Förklarliga algoritmer ger förklaringar som är felaktiga per definition - annars skulle den komplexa svarta lådans inre funktion vara onödig. Medan en förklaringsmodell kan ge liknande eller till och med exakta resultat som den ursprungliga svarta lådans algoritm, det finns inget sätt att veta om den använder samma parametrar eller inte.

"Om en tiondel av förklaringarna är fel, du kan inte lita på förklaringarna, och därför kan du inte lita på den ursprungliga svarta lådan, " säger Rudin. "Om vi inte kan veta säkert om vår förklaring är korrekt, vi kan inte veta om vi ska lita på vare sig förklaringen eller den ursprungliga modellen."

Mer är inte lika bättre

Människor antar vanligtvis att bara för att en maskininlärningsalgoritm är komplicerad, att den är mer exakt än en enkel. Men denna övertygelse är ogrundad.

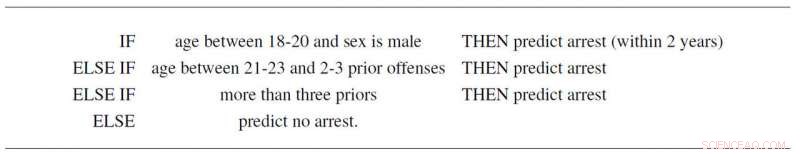

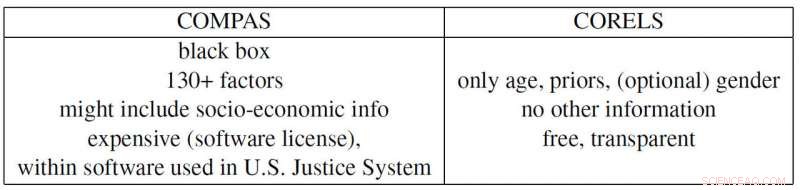

Till exempel, Rudin och medarbetare Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone och Daniel Alabi har skapat en enkel tolkningsbar modell för brottslig återfall baserad på enbart ålder, kön och tidigare rekord. Det följer inte bara tre enkla regler som alla kan förstå, den förutspår sannolikheten för framtida arresteringar lika väl som det kontroversiella programmet "COMPAS", som är flitigt använt i det amerikanska rättssystemet. Och förutom att vara en svart låda som många misstänker använder sig av rasistiska fördomar, COMPAS använder mer än 130 delar av information för att göra sina förutsägelser, vilket är ett stort problem av sig självt.

"Om personer som anger dessa uppgifter gör ett typografiskt fel bara en procent av tiden, då kommer mer än 1 av varannan undersökning i genomsnitt ha minst ett misstag, " säger Rudin. "Dessutom kan en alltför komplicerad black box-modell vara defekt utan att någon inser det, eftersom det är svårt att felsöka."

Propublica-exemplet

ProPublica anklagade nyligen COMPAS recidivism black box-algoritmen för att vara rasistisk eftersom de skapade en förklarlig modell baserad på ras som återger COMPAS resultat. Men eftersom samhälleliga påtryckningar har skapat ett straffrättssystem där kriminell historia och ålder är korrelerade med ras i varje datauppsättning, den faktiska COMPAS svarta lådan kanske faktiskt bara förlitar sig på de två första variablerna. Men å andra sidan, det kan också vara att använda ras som en faktor precis som ProPublica hävdar. Problemet är att det är omöjligt att säga eftersom COMPAS är en (dyr) proprietär svart låda som ingen annan än dess ägare kan titta in i.

Rudin pekar också på flera andra samtida problematiska exempel. Den patenterade svarta lådan BreezoMeter sa till användare i Kalifornien att deras luftkvalitet var helt ok när luftkvaliteten var farligt dålig enligt flera andra modeller. En maskininlärningsmodell designad för att läsa röntgenstrålar uppfattade ordet "bärbar" i en röntgenbild, representerar typen av röntgenutrustning snarare än det medicinska innehållet i bilden, och därmed rapportera dåliga slutsatser.

"Det finns en ansvarskonflikt när det gäller användningen av svarta lådmodeller för beslut med hög insats. Företagen som tjänar på dessa modeller är inte nödvändigtvis ansvariga för kvaliteten på individuella förutsägelser, " säger Rudin. "En fånge som avtjänar ett alltför långt straff på grund av ett misstag i en alltför komplicerad riskpoäng kan lida i flera år, medan företaget som konstruerade denna modell drar nytta av dess komplexitet och anständighet. I det avseendet, modellens designers är inte motiverade att vara försiktiga i sin design, prestanda och användarvänlighet. Det här är några av samma typer av problem som drabbar de kreditvärderingsinstitut som prissatte bolån 2008."

"Jag hoppas att folk inser riskerna med förklarliga modeller och att de faktiskt inte behöver svarta lådor alls. De kan använda modeller som är helt tolkbara, " säger Rudin. "Jag skulle vilja se ett system där ingen black box-algoritm används för ett höginsatsbeslut såvida det inte finns en lika exakt tolkningsbar modell. Jag har arbetat med många olika applikationer—sjukvård, energi, kreditrisk, kriminella återfall, datorseende — och jag har aldrig hittat ett program där en svart låda faktiskt behövs."