En banner med texten "Den islamiska staten" visas på Facebook-sidan för en användare som identifierar sig som Nawan Al-Farancsa. Sidan var fortfarande live på tisdag, 7 maj, 2019, när skärmgreppet gjordes. Facebook säger att de har robusta system på plats för att ta bort innehåll från extremistgrupper, men en förseglad whistleblower-klagomål som granskats av AP säger att förbjudet innehåll finns kvar på webben och är lätt att hitta. (Facebook via AP)

Den animerade videon börjar med ett foto av jihads svarta flaggor. Sekunder senare, den visar höjdpunkter från ett år av inlägg på sociala medier:plaketter med antisemitiska verser, tal om vedergällning och ett foto på två män som bär fler jihadistiska flaggor medan de bränner stjärnorna och ränderna.

Den producerades inte av extremister; det skapades av Facebook. I en smart bit av självreklam, sociala mediejätten tar ett år av en användares innehåll och genererar automatiskt en celebratorisk video. I detta fall, användaren kallade sig "Abdel-Rahim Moussa, kalifatet."

"Tack för att du är här, från Facebook, " videon avslutas i en tecknad bubbla innan företagets berömda "tummen upp."

Facebook gillar att ge intrycket att det ligger före extremister genom att ta ner deras inlägg, ofta innan användarna ens ser dem. Men en konfidentiell whistleblower-klagomål till Securities and Exchange Commission som The Associated Press inhämtade hävdar att företaget för sociala medier har överdrivit sin framgång. Ännu värre, det visar att företaget oavsiktligt använder sig av propaganda från militanta grupper för att automatiskt generera videor och sidor som kan användas för nätverkande av extremister.

Enligt klagomålet under en femmånadersperiod förra året, forskare övervakade sidor av användare som anslutit sig till grupper som det amerikanska utrikesdepartementet har utsett som terroristorganisationer. Under den perioden, 38 % av inläggen med framträdande symboler för extremistiska grupper togs bort. I sin egen recension, AP fann att från och med denna månad, mycket av det förbjudna innehållet som citeras i studien – en avrättningsvideo, bilder av avhuggna huvuden, propaganda för att hedra militanta martyrer – gled genom den algoritmiska webben och förblev lätt att hitta på Facebook.

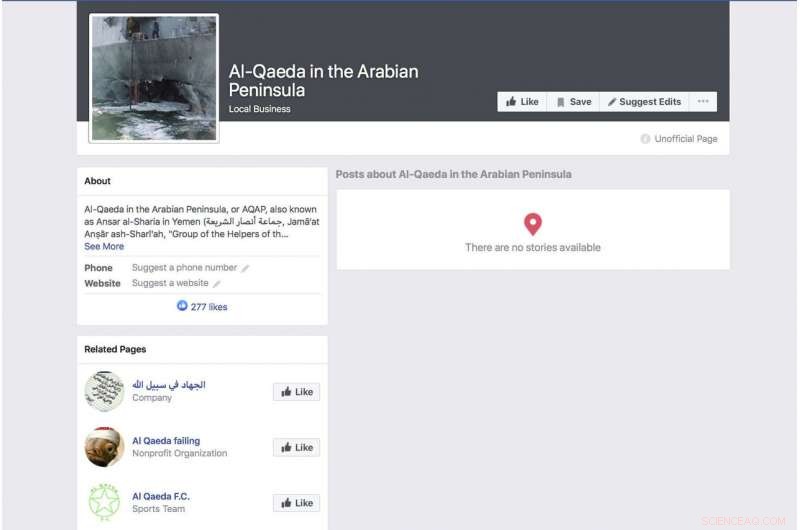

En automatiskt genererad Facebook-sida för en grupp som identifierar sig som terrorgruppen "Al-Qaida på den arabiska halvön" visar ett foto av det bombade amerikanska flottans krigsfartyg USS Cole. Sidan var fortfarande aktiv från och med tisdagen, 7 maj, 2019, när skärmgreppet gjordes. Facebook säger att de har robusta system på plats för att ta bort innehåll från extremistgrupper, men en förseglad whistleblower-klagomål som granskats av AP säger att förbjudet innehåll finns kvar på webben och lätt att hitta. (Facebook via AP)

Klagomålet landar när Facebook försöker ligga steget före en växande mängd kritik över dess sekretesspraxis och dess förmåga att behålla hatretorik, livestreamade mord och självmord utanför dess tjänst. Inför kritiken, VD Mark Zuckerberg har talat om sin stolthet över företagets förmåga att sålla bort våldsamma inlägg automatiskt genom artificiell intelligens. Under ett intäktssamtal förra månaden, till exempel, han upprepade en noggrant formulerad formulering som Facebook har använt.

"I områden som terrorism, för al-Qaida och ISIS-relaterat innehåll, nu 99 procent av innehållet som vi tar ner i kategorin som våra system flaggar proaktivt innan någon ser det, sa han. Sedan tillade han:"Så här ser riktigt bra ut."

Zuckerberg gav ingen uppskattning av hur mycket av det totala förbjudna materialet som tas bort.

Forskningen bakom SEC-klagomålet syftar till att belysa uppenbara brister i företagets tillvägagångssätt. Förra året, forskare började övervaka användare som uttryckligen identifierade sig som medlemmar i extremistgrupper. Det var inte svårt att dokumentera. Vissa av dessa personer anger till och med extremistgrupperna som sina arbetsgivare. En profil som förebådas av den svarta flaggan från en al-Qaida-ansluten grupp listade hans arbetsgivare, kanske fasansfullt, som Facebook. Profilen som inkluderade den automatiskt genererade videon med flaggan brinnande hade också en video av al-Qaida-ledaren Ayman al-Zawahiri som uppmanade jihadistgrupper att inte slåss sinsemellan.

Även om studien är långt ifrån heltäckande – delvis på grund av att Facebook sällan gör mycket av sin data tillgänglig för allmänheten – säger forskare som är involverade i projektet att det är lätt att identifiera dessa profiler med en grundläggande nyckelordssökning och det faktum att så få av dem har tagits bort. att Facebooks påståenden att dess system fångar upp det mesta extremistiskt innehåll inte stämmer.

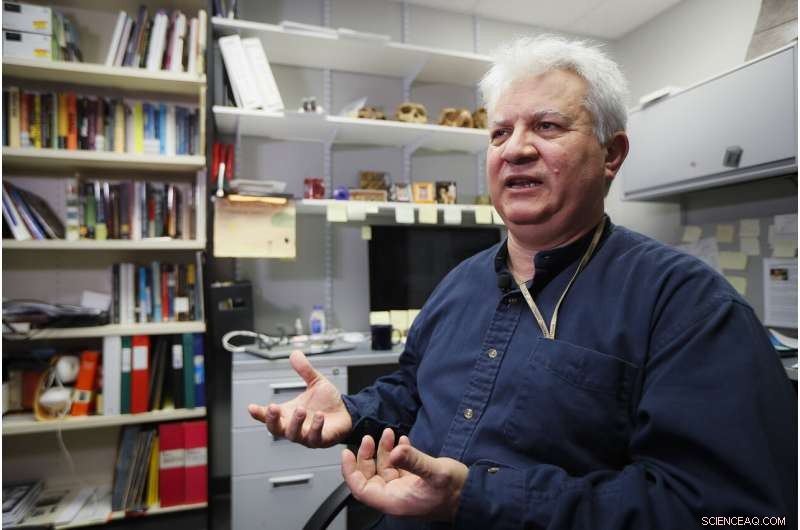

Amr Al Azm, professor i Mellanösterns historia och antropologi vid Shawnee State University, talar på sitt kontor den 25 april, 2019, i Portsmouth, Ohio. Facebook ger intrycket att det stoppar de allra flesta extremistiska inlägg innan användarna någonsin ser dem. Men en konfidentiell whistleblower-klagomål till Securities and Exchange Commission som The Associated Press inhämtade hävdar att företaget för sociala medier har överdrivit sin framgång. "Jag menar att det bara sträcker fantasin till bortom vantro, " säger, Al Azm en av forskarna som är involverade i projektet. "Om en liten grupp forskare kan hitta hundratals sidor med innehåll genom enkla sökningar, varför kan inte ett jätteföretag med alla sina resurser göra det?" (AP Photo/John Minchillo)

"Jag menar, det är bara att sträcka fantasin till bortom vantro, " säger Amr Al Azm, en av forskarna som är involverade i projektet. "Om en liten grupp forskare kan hitta hundratals sidor med innehåll genom enkla sökningar, varför kan inte ett jätteföretag med alla sina resurser göra det?"

Al Azm, en professor i historia och antropologi vid Shawnee State University i Ohio, har också styrt en grupp i Syrien som dokumenterar plundring och smuggling av antikviteter.

Facebook medger att dess system inte är perfekta, men säger att det gör förbättringar.

"Efter att ha gjort stora investeringar, vi upptäcker och tar bort terrorisminnehåll med en mycket högre framgångsfrekvens än för två år sedan, ", sade företaget i ett uttalande. "Vi gör inte anspråk på att hitta allt och vi är fortsatt vaksamma i våra ansträngningar mot terroristgrupper runt om i världen."

Reagerar på AP:s rapportering, Rep. Bennie Thompson, D-fröken, ordföranden för House Homeland Security Committee uttryckte frustration över att Facebook har gjort så små framsteg när det gäller att blockera innehåll trots försäkran han fått från företaget.

En Facebook-sida för användaren Ramadan kareem, att när den översatts till engelska listar användaren som arbetar på "Islamiska staten i Sham och Irak." Sidan var fortfarande live på tisdag, 7 maj, 2019, när skärmgreppet gjordes. Facebook säger att de har robusta system på plats för att ta bort innehåll från extremistgrupper, men en förseglad whistleblower-klagomål som granskats av AP säger att förbjudet innehåll finns kvar på webben och lätt att hitta. (Facebook via AP)

"Detta är ännu ett djupt oroande exempel på Facebooks oförmåga att hantera sina egna plattformar - och i vilken utsträckning de behöver städa upp sin handling, " sa han. "Facebook måste inte bara befria sina plattformar från terrorist- och extremistiskt innehåll, men den måste också kunna förhindra att den förstärks."

Men som en skarp indikation på hur lätt användare kan undvika Facebook, en sida från en användare som heter "Nawan al-Farancsa" har en rubrik vars vita bokstäver mot en svart bakgrund säger på engelska "The Islamic State." Banderollen präglas av ett foto av ett explosivt svampmoln som stiger upp från en stad.

Profilen borde ha fångat Facebooks uppmärksamhet — såväl som kontraspionagebyråer. Den skapades i juni 2018, listar användaren som kommer från Tjetjenien, en gång en militant hotspot. Det står att han bodde i Heidelberg, Tyskland, och studerade vid ett universitet i Indonesien. Några av användarens vänner postade också militant innehåll.

Sidan, fortfarande uppe de senaste dagarna, uppenbarligen flydde Facebooks system, på grund av ett uppenbart och långvarigt undvikande av måttfullhet som Facebook borde vara skickligt på att känna igen:Bokstäverna var inte sökbar text utan inbäddade i ett grafiskt block. Men företaget säger att dess teknik skannar ljud, video och text – inklusive när det är inbäddat – för bilder som speglar våld, vapen eller logotyper för förbjudna grupper.

Den sociala nätverksjätten har uthärdat två svåra år med början 2016, när Rysslands användning av sociala medier för att blanda sig i det amerikanska presidentvalet hamnade i fokus. Zuckerberg tonade till en början ned rollen som Facebook spelade i den ryska underrättelsetjänstens påverkansoperation, men företaget bad senare om ursäkt.

En Facebook-sida för en användare som översätts till engelska som "Lights of bitterness" som listar användaren som läkare vid Islamiska staten. Sidan var fortfarande aktiv från och med tisdagen, 7 maj, 2019, när skärmgreppet gjordes. Facebook säger att de har robusta system på plats för att ta bort innehåll från extremistgrupper, men ett klagomål från en whistleblower som granskats av AP säger att förbjudet innehåll finns kvar på webben och lätt att hitta. (Facebook via AP)

Facebook säger att de nu har 30 anställda, 000 personer som arbetar med dess säkerhets- och säkerhetsrutiner, granska potentiellt skadligt material och allt annat som kanske inte hör hemma på webbplatsen. Fortfarande, företaget sätter mycket av sin tilltro till artificiell intelligens och dess system förmåga att så småningom sålla bort dåliga saker utan hjälp av människor. Den nya forskningen tyder på att målet är långt borta och vissa kritiker hävdar att företaget inte gör en uppriktig ansträngning.

När materialet inte tas bort, det behandlas på samma sätt som allt annat som postats av Facebooks 2,4 miljarder användare – hyllats i animerade videor, länkade och kategoriserade och rekommenderas av algoritmer.

Men det är inte bara algoritmerna som bär skulden. Forskarna fann att vissa extremister använder Facebooks "Frame Studio" för att lägga upp militant propaganda. Verktyget låter människor dekorera sina profilfoton inom grafiska ramar – för att stödja ändamål eller fira födelsedagar, till exempel. Facebook säger att de inramade bilderna måste godkännas av företaget innan de läggs upp.

Hany Farid, en digital forensicsexpert vid University of California, Berkeley, som ger råd till Counter-Extremism Project, en New York- och London-baserad grupp fokuserad på att bekämpa extremistiska budskap, säger att Facebooks artificiella intelligenssystem brister. Han säger att företaget inte är motiverat att ta itu med problemet eftersom det skulle bli dyrt.

"Hela infrastrukturen är fundamentalt felaktig, ", sa han. "Och det finns väldigt lite aptit att fixa det eftersom vad Facebook och de andra sociala medieföretagen vet är att när de väl börjar ansvara för material på sina plattformar så öppnar det upp en hel burk med maskar."

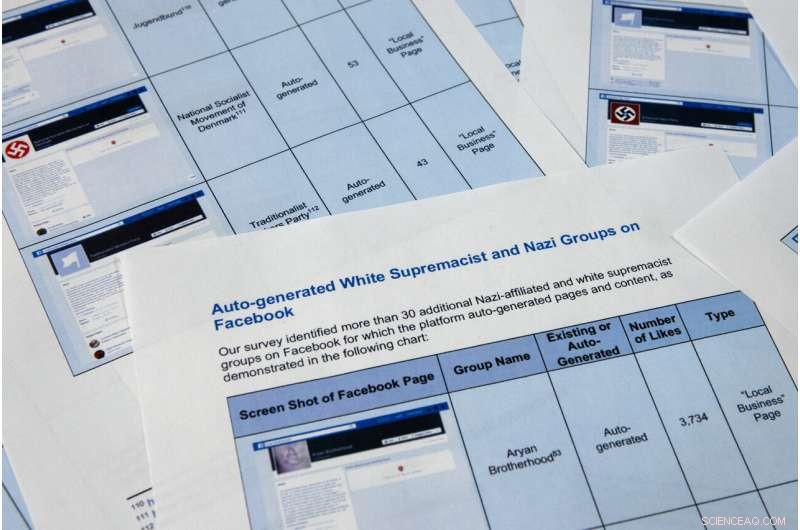

Sidor från en konfidentiell whistleblower-rapport som erhållits av Associated Press är fotograferade på tisdag, 7 maj, 2019, i Washington. Facebook gillar att ge intrycket att det stoppar de allra flesta extremistiska inlägg innan användarna någonsin ser dem., men den konfidentiella whistleblowerens klagomål till Securities and Exchange Commission hävdar att företaget för sociala medier har överdrivit sin framgång. Ännu värre, det visar att företaget använder sig av propaganda från militanta grupper för att automatiskt generera videor och sidor som kan användas för nätverkande av extremister. (AP Photo/Jon Elswick)

Sidor från en konfidentiell whistleblower-rapport som erhållits av Associated Press är fotograferade på tisdag, 7 maj, 2019, i Washington. Facebook gillar att ge intrycket att det stoppar de allra flesta extremistiska inlägg innan användarna någonsin ser dem., men den konfidentiella whistleblowerens klagomål till Securities and Exchange Commission hävdar att företaget för sociala medier har överdrivit sin framgång. Ännu värre, det visar att företaget använder sig av propaganda från militanta grupper för att automatiskt generera videor och sidor som kan användas för nätverkande av extremister. Forskarna i SEC-klagomålet identifierade över 30 autogenererade sidor för vita supremacistgrupper, vars innehåll Facebook förbjuder. (AP Photo/Jon Elswick)

I denna 11 april, 2018, fil foto, Facebooks vd Mark Zuckerberg vittnar inför en utfrågning av House Energy and Commerce på Capitol Hill i Washington. Facebook ger intrycket att det stoppar de allra flesta extremistiska inlägg innan användarna någonsin ser dem. Men ett konfidentiellt whistleblower-klagomål till Securities and Exchange Commission som erhållits av Associated Press hävdar att företaget för sociala medier har överdrivit sin framgång. (AP Photo/Andrew Harnik, Fil)

En annan Facebook-funktion för automatisk generering som gått snett skrapar anställningsinformation från användarnas sidor för att skapa affärssidor. Funktionen är tänkt att producera sidor som ska hjälpa företag att nätverka, men i många fall tjänar de som en brandplats för extremistgrupper. Funktionen låter Facebook-användare gilla sidor för extremistiska organisationer, inklusive al-Qaida, gruppen Islamiska staten och somaliskt baserade al-Shabab, ger effektivt en lista över sympatisörer för rekryterare.

Överst på en automatiskt genererad sida för al-Qaida på den arabiska halvön, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. I mars, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, 7 maj, 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook via AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Till exempel, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " säger, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 Associated Press. Alla rättigheter förbehållna.