Kredit:openai

Forskare har gjort nyheter för att låta sina AI -ambitioner spela ett formidabelt gömställe med fantastiska resultat. Agenternas miljö hade väggar och flyttbara lådor för en utmaning där några var gömmerna och andra, sökande. Mycket hände på vägen, med överraskningar.

Med besked om vad man lärt sig, författarna bloggade:"Vi har observerat agenter som upptäcker gradvis mer komplex verktygsanvändning medan de spelar ett enkelt spel av göm-och-sök, "där agenterna byggde" en serie med sex olika strategier och motstrategier, Vissa av dem visste vi inte att vår miljö stödde. "

I en ny tidning som släpptes tidigare i veckan, laget avslöjade resultat. Deras papper, "Emergent Tool Use from Multi-Agent Autocurricula, "hade sju författare, varav sex hade OpenAI -representation listad, och en, Google Brain.

Författarna kommenterade vilken typ av utmaning de tog sig an. "Att skapa intelligenta konstgjorda agenter som kan lösa en mängd olika komplexa mänskligt relevanta uppgifter har varit en långvarig utmaning inom artificiell intelligens."

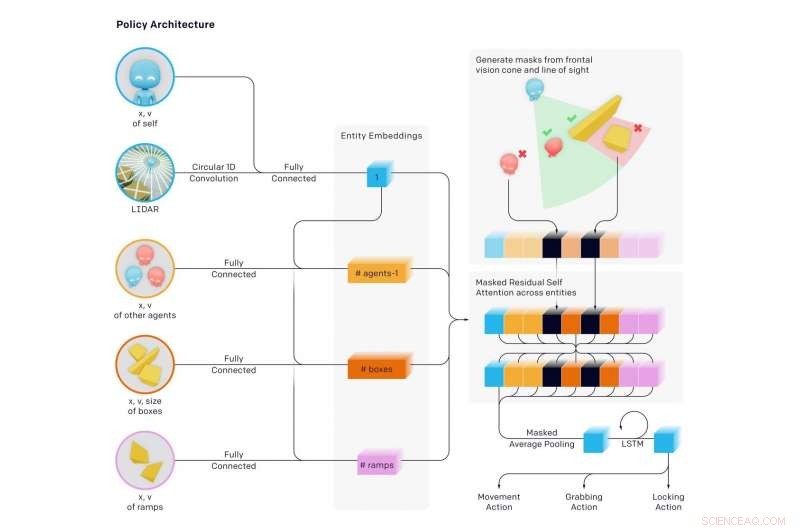

Teamet sa att "vi finner att agenter skapar en självövervakad autokurrik som framkallar flera distinkta omgångar av framväxande strategi, varav många kräver sofistikerad verktygsanvändning och samordning. "

Genom göm-och-sök, (1) Sökare lärde sig jaga gömare och gömare lärde sig springa iväg (2) Gömare lärde sig grundläggande verktygsanvändning - lådor och väggar för att bygga fort. (3) Sökare lärde sig att använda ramper för att hoppa in i gömstugor (4) Gömare lärde sig att flytta ramper långt ifrån där de ska bygga sitt fort, och lås dem på plats (5) Sökare lärde sig att de kan hoppa från låsta ramper till lådor och surfa i rutan till gömarnas skydd och (6) Gömare lärde sig att låsa de oanvända lådorna innan de byggde sitt fort.

Dessa sex strategier framkom när agenter tränade mot varandra i göm-och-sök-varje ny strategi skapade ett tidigare obefintligt tryck för agenter att gå vidare till nästa steg, utan några direkta incitament för agenter att interagera med objekt eller att utforska. Strategierna var ett resultat av "autokurriken" som framkallats av konkurrens med flera agenter och dynamik i göm-och-sök.

Författarna i bloggen sa att de lärt sig "det är ganska ofta så att agenter hittar ett sätt att utnyttja den miljö du bygger eller fysikmotorn på ett oavsiktligt sätt."

Det som hände var en "självövervakad framväxande komplexitet". Och detta "tyder vidare på att multi-agent co-adaptation en dag kan ge extremt komplext och intelligent beteende." Författarna uttalade på samma sätt i sin artikel att "inducering av autokurrikuler i fysiskt grundade och öppna miljöer så småningom kan göra det möjligt för agenter att förvärva ett obegränsat antal mänskligt relevanta färdigheter."

Douglas Heaven, Ny forskare , väckte verkligen läsarnas intresse för hur han beskrev vad som hände:

"I början, gömarna sprang helt enkelt iväg. Men, de kom snart fram till att det snabbaste sättet att stubba sökarna var att hitta föremål i miljön för att gömma sig från syn, använda dem som ett slags verktyg. Till exempel, de lärde sig att lådor kan användas för att blockera dörröppningar och bygga enkla gömställen. Sökarna fick veta att de kunde flytta en ramp runt och använda den för att klättra över väggar. Botarna upptäckte sedan att att vara en lagspelare-att förmedla objekt till varandra eller att samarbeta i ett gömställe-var det snabbaste sättet att vinna. "

Detta var ett ambitiöst projekt. Undersöker deras arbete, MIT Technology Review noterade att AI lärde sig att använda verktyg efter nästan 500 miljoner spel av göm och sök. Genom att spela göm och sök hundratals miljoner omgångar, två motsatta team av AI -agenter utvecklade komplexa göm- och sökstrategier.

Karen Hao presenterade en intressant markör för vad agenterna lärde sig efter hur många omgångar:"... runt 25-miljoners-spelet, spelet blev mer sofistikerat. Gömarna lärde sig att flytta och låsa lådorna och spärrarna i miljön för att bygga fort runt sig själva så att de som söker aldrig skulle se dem. "

Fler miljoner omgångar:sökande upptäckte en motstrategi, när de lärde sig att flytta en ramp bredvid gömmarnas fort och använda den för att klättra över väggarna. Fler omgångar senare, gömmarna lärde sig att låsa ramperna på plats innan de byggde sitt fort.

Ytterligare fler strategier dök upp vid 380 miljoner spel. ytterligare två strategier framkom. Sökarna utvecklade en strategi för att bryta sig in i gömmarnas fort genom att använda en låst ramp för att klättra upp på en olåst låda, "surfa" sedan på toppen av lådan till fortet och över dess väggar. I slutskedet, gömmarna lärde sig återigen låsa alla ramper och lådor på plats innan de byggde sitt fort.

Hao citerade Bowen Baker, en av författarna till tidningen. "Vi sa inte till gömmarna eller sökarna att springa nära en låda eller interagera med den ... Men genom multiagent -tävling, de skapade nya uppgifter för varandra så att det andra laget var tvungen att anpassa sig. "

Tänk på det. Baker sa att de inte berättade för gömmarna, och de berättade inte för sökarna, att springa nära lådor eller att interagera med dem.

Devin Coldewey in TechCrunch tänkt på det. "Studien avsåg, och framgångsrikt undersökte möjligheten för maskininlärningsagenter att lära sig sofistikerade, verkliga tekniker utan någon inblandning av förslag från forskarna. "

Coldewey spikade hemkörningen för allt detta arbete. "Som författarna till tidningen förklarar, det var på det här sättet vi kom fram. "

Vi, som hos människor. Coldewey citerade en passage från deras papper.

"Den stora mängden komplexitet och mångfald på jorden utvecklades på grund av samutveckling och konkurrens mellan organismer, styrs av naturligt urval. När en ny framgångsrik strategi eller mutation dyker upp, det förändrar den implicita uppgiftsfördelningen som grannagenter behöver lösa och skapar ett nytt tryck för anpassning. Dessa evolutionära vapenlopp skapar implicita autokurricula där konkurrerande agenter ständigt skapar nya uppgifter för varandra. "

© 2019 Science X Network