I scoututforskningsspelet, för att anpassa sig till mänskliga värderingar, lär sig roboten av mänsklig feedback till förslagen. Bildkredit:Zhen Chen@BIGAI.

Artificiell intelligens (AI)-metoder har blivit alltmer avancerade under de senaste decennierna, och uppnått anmärkningsvärda resultat i många verkliga uppgifter. Ändå delar de flesta befintliga AI-system inte sina analyser och stegen som ledde till deras förutsägelser med mänskliga användare, vilket kan göra en tillförlitlig utvärdering av dem extremt utmanande.

En grupp forskare från UCLA, UCSD, Peking University och Beijing Institute for General Artificial Intelligence (BIGAI) har nyligen utvecklat ett nytt AI-system som kan förklara dess beslutsprocesser för mänskliga användare. Detta system, introducerat i en artikel publicerad i Science Robotics , kan vara ett nytt steg mot skapandet av mer pålitlig och begriplig AI.

"Fältet för förklarlig AI (XAI) syftar till att bygga upp förtroende för samarbete mellan robotar och människor, och DARPA XAI-projektet fungerade som en stor katalysator för att avancera forskning inom detta område," Dr. Luyao Yuan, en av de första författarna till artikeln , berättade för TechXplore. "I början av DARPA XAI-projektet fokuserar forskargrupper i första hand på att inspektera modeller för klassificeringsuppgifter genom att avslöja beslutsprocessen för AI-system för användaren; till exempel kan vissa modeller visualisera vissa lager av CNN-modeller, som påstår sig uppnå en viss nivå av XAI."

Dr. Yuan och hans kollegor deltog i DARPA XAI-projektet, som specifikt syftade till att utveckla nya och lovande XAI-system. När de deltog i projektet började de reflektera över vad XAI skulle innebära i bredare bemärkelse, särskilt på effekterna det kan ha på samarbeten mellan människor och maskin.

Teamets senaste artikel bygger på ett av deras tidigare arbeten, även publicerat i Science Robotics , där teamet undersökte vilken inverkan som förklarbara system kan ha på en användares uppfattningar och förtroende för AI under interaktioner mellan människa och maskin. I sin tidigare studie implementerade och testade teamet ett AI-system fysiskt (dvs i den verkliga världen), medan de i sin nya studie testade det i simuleringar.

"Vårt paradigm står i kontrast till nästan alla de som föreslagits av team i DARPA XAI-programmet, som i första hand fokuserade på vad vi kallar det passiva maskinaktiva användarparadigmet", säger professor Yixin Zhu, en av projektets handledare, till TechXplore. "I dessa paradigm måste mänskliga användare aktivt kontrollera och försöka ta reda på vad maskinen gör (därmed 'aktiv användare') genom att utnyttja några modeller som avslöjar AI-modellernas potentiella beslutsprocess."

XAI-system som följer vad Prof. Zhu refererar till som "passiv maskinaktiv användare"-paradigmet kräver att användare ständigt checkar in med AI för att förstå processerna bakom dess beslut. I detta sammanhang påverkar inte en användares förståelse av en AI:s processer och förtroende för dess förutsägelser AI:s framtida beslutsprocesser, vilket är anledningen till att maskinen kallas "passiv".

Däremot följer det nya paradigmet som introducerats av Dr. Yuan, Prof. Zhu och deras kollegor vad teamet refererar till som ett aktivt maskinaktivt användarparadigm. Detta innebär i huvudsak att deras system aktivt kan lära sig och anpassa sitt beslutsfattande baserat på den feedback det får av användare i farten. Denna förmåga att kontextuellt anpassa sig är karakteristisk för vad som ofta kallas den tredje/nästa vågen av AI.

"För att ha AI-system som hjälper sina användare som vi förväntar oss att de ska, kräver nuvarande system att användaren kodar i expertdefinierade mål," sa Dr. Yuan. "Detta begränsar potentialen för människa-maskin-teaming, eftersom sådana mål kan vara svåra att definiera i många uppgifter, vilket gör AI-system otillgängliga för de flesta. För att lösa detta problem gör vårt arbete det möjligt för robotar att uppskatta användarnas avsikter och värderingar under samarbetet i realtid, vilket sparar behovet av att koda komplicerade och specifika mål till robotarna i förväg, vilket ger ett bättre samarbetsparadigm mellan människa och maskin."

Målet med systemet skapat av Dr. Yuan och hans kollegor är att uppnå så kallad "värdeanpassning." Detta betyder i huvudsak att en mänsklig användare kan förstå varför en robot eller maskin agerar på ett specifikt sätt eller kommer till specifika slutsatser, och att maskinen eller roboten kan sluta sig till varför den mänskliga användaren agerar på ett specifikt sätt. Detta kan förbättra kommunikationen mellan människa och robot avsevärt.

"Denna dubbelriktade karaktär och realtidsprestandan är de största utmaningarna med problemet och höjdpunkten i våra bidrag," sa prof. Zhu. "När vi sammanställer ovanstående punkter tror jag att du nu kommer att förstå varför vår artikels titel är "In situ dubbelriktad värdeanpassning mellan människa och robot."

För att träna och testa sitt XAI-system designade forskarna ett spel som heter "scout exploration", där människor måste slutföra en uppgift i lag. En av de viktigaste aspekterna av detta spel är att människor och robotar måste anpassa sina så kallade "värdefunktioner".

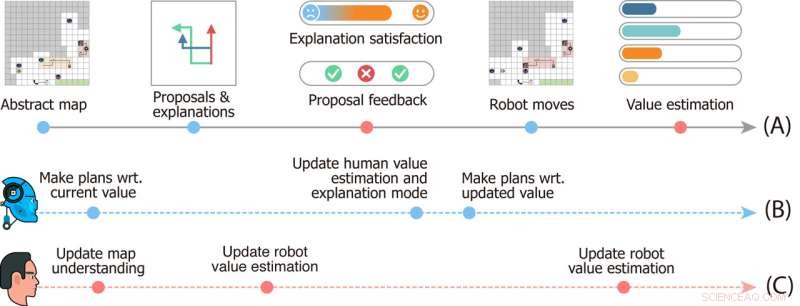

Studiedesign av Scout Exploration Game. Tidslinje (A) anger händelser som händer i en enda omgång av spelet. Tidslinjer (B) och (C) skildrar robotarnas och användarens mentala dynamik. Bildkredit:Zhen Chen@BIGAI.

"I spelet kan en grupp robotar uppfatta miljön; detta emulerar verkliga applikationer där gruppen av robotar är tänkt att arbeta autonomt för att minimera mänskliga ingrepp", sa prof. Zhu. "Den mänskliga användaren kan dock inte interagera direkt med omgivningen; istället fick användaren en speciell värdefunktion, representerad av betydelsen av ett fåtal faktorer (t.ex. den totala tiden för att slutföra tiden och resurser som samlats in på språnget )."

I scoututforskningsspelet har teamet av robotar inte tillgång till värdefunktionen som ges till mänskliga användare, och de måste sluta sig till det. Eftersom detta värde inte enkelt kan uttryckas och kommuniceras måste roboten och det mänskliga teamet sluta sig till det från varandra för att slutföra uppgiften.

"Kommunikationen är dubbelriktad i spelet:å ena sidan föreslår roboten flera uppgiftsplaner för användaren och förklarar för- och nackdelarna för var och en av dem, och å andra sidan ger användaren feedback på förslagen och betygsätter varje förklaring, " Dr. Xiaofeng Gao, en av de första författarna av tidningen, berättade för TechXplore. "Dessa dubbelriktade kommunikationer möjliggör vad som kallas värdejustering."

I grund och botten, för att utföra uppgifter i "scoututforskning", måste teamet av robotar förstå vad de mänskliga användarnas värdefunktion helt enkelt är baserat på människans feedback. Samtidigt lär sig mänskliga användare robotarnas aktuella värdeuppskattningar och kan ge feedback som hjälper dem att förbättra och i slutändan vägleder dem mot rätt svar.

"Vi har också integrerat theory of mind i vår beräkningsmodell, vilket gör det möjligt för AI-systemet att generera korrekta förklaringar för att avslöja dess nuvarande värde och uppskatta användarnas värde från deras feedback i realtid under interaktionen," sa Dr. Gao. "Vi genomförde sedan omfattande användarstudier för att utvärdera vårt ramverk."

I de första utvärderingarna uppnådde systemet som skapats av Dr. Yuan, Prof. Zhu, Dr. Gao och deras kollegor anmärkningsvärda resultat, vilket ledde till att värderingar i scoututforskningsspelet i farten och på ett interaktivt sätt anpassades till varandra. Teamet fann att roboten anpassade sig till den mänskliga användarens värdefunktion så tidigt som 25 % in i spelet, medan användarna kunde få exakta uppfattningar om maskinens värdefunktioner ungefär halvvägs in i spelet.

"Parningen av konvergens (i) från robotarnas värde till användarens sanna värden och (ii) från användarens uppskattning av robotarnas värden till robotarnas nuvarande värden bildar en dubbelriktad värdejustering förankrad av användarens sanna värde," Dr. sa Yuan. "Vi tror att vårt ramverk belyser nödvändigheten av att bygga intelligenta maskiner som lär sig och förstår våra avsikter och värderingar genom interaktioner, vilket är avgörande för att undvika många av de dystopiska science fiction-berättelserna som skildras i romaner och på den stora skärmen."

Det senaste arbetet av detta team av forskare är ett betydande bidrag till forskningsområdet med fokus på utveckling av mer begriplig AI. Systemet de föreslog skulle kunna tjäna som inspiration för skapandet av andra XAI-system där robotar eller smarta assistenter aktivt engagerar sig med människor, delar deras processer och förbättrar deras prestanda baserat på feedbacken de får från användarna.

"Värdeanpassning är vårt första steg mot generiskt samarbete mellan människa och robot," förklarade Dr. Yuan. "I detta arbete sker värdeanpassning i samband med en enskild uppgift. Men i många fall samarbetar en grupp agenter i många uppgifter. Till exempel förväntar vi oss att en hushållsrobot hjälper oss med många dagliga sysslor, istället för att köpa många robotar, var och en bara kan utföra en typ av jobb."

Hittills har forskarnas XAI-system uppnått mycket lovande resultat. I sina nästa studier planerar Dr. Yuan, Prof. Zhu, Dr. Gao och deras kollegor att utforska fall av värdeanpassning mellan människa och robot som kan tillämpas på många olika verkliga uppgifter, så att mänskliga användare och AI-agenter kan ackumuleras information som de fått om varandras processer och förmågor när de samarbetar kring olika uppgifter.

"I våra nästa studier försöker vi också tillämpa vårt ramverk på fler uppgifter och fysiska robotar," sa Dr. Gao. "Förutom värderingar tror vi att att anpassa andra aspekter av mentala modeller (t.ex. övertygelser, önskningar, avsikter) mellan människor och robotar också skulle vara en lovande riktning."

Forskarna hoppas att deras nya förklarliga AI-paradigm kommer att bidra till att förbättra samarbetet mellan människor och maskiner i många uppgifter. Dessutom hoppas de att deras tillvägagångssätt kommer att öka människors förtroende för AI-baserade system, inklusive smarta assistenter, robotar, bots och andra virtuella agenter.

"Till exempel kan du korrigera Alexa eller Google Home när det gör ett fel, men det kommer att göra samma fel nästa gång du använder det," tillade prof. Zhu. "När din Roomba åker någonstans som du inte vill att den ska gå och försöker bekämpa den, förstår den inte eftersom den bara följer den fördefinierade AI-logiken. Alla dessa förbjuder modern AI från att gå in i våra hem. Som den första steg visar vårt arbete potentialen i att lösa dessa problem, ett steg närmare att uppnå vad DARPA kallade "kontextuell anpassning" i den tredje vågen av AI." + Utforska vidare

© 2022 Science X Network