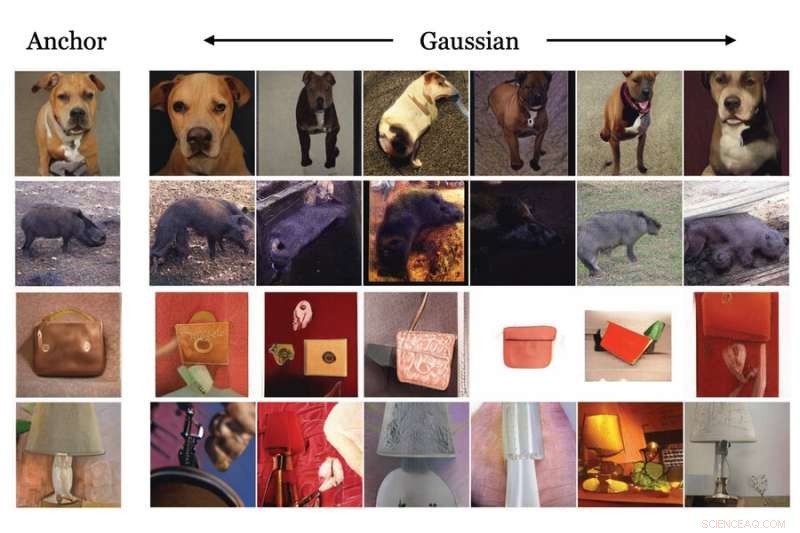

MIT-forskare har demonstrerat användningen av en generativ maskininlärningsmodell för att skapa syntetisk data, baserad på verklig data, som kan användas för att träna en annan modell för bildklassificering. Den här bilden visar exempel på den generativa modellens transformationsmetoder. Kredit:Massachusetts Institute of Technology

Enorma mängder data behövs för att träna maskininlärningsmodeller för att utföra bildklassificeringsuppgifter, som att identifiera skador på satellitbilder efter en naturkatastrof. Dessa uppgifter är dock inte alltid lätta att få tag på. Datauppsättningar kan kosta miljontals dollar att generera, om användbar data finns i första hand, och även de bästa datauppsättningarna innehåller ofta fördomar som negativt påverkar en modells prestanda.

För att kringgå några av problemen med datauppsättningar utvecklade MIT-forskare en metod för att träna en maskininlärningsmodell som, snarare än att använda en datauppsättning, använder en speciell typ av maskininlärningsmodell för att generera extremt realistisk syntetisk data som kan träna en annan modell för nedströms vision uppgifter.

Deras resultat visar att en inlärningsmodell för kontrastiv representation som tränas med enbart dessa syntetiska data kan lära sig visuella representationer som konkurrerar med eller till och med överträffar dem som lärts från verkliga data.

Denna speciella maskininlärningsmodell, känd som en generativ modell, kräver mycket mindre minne att lagra eller dela än en datauppsättning. Att använda syntetisk data har också potentialen att kringgå vissa farhågor kring integritet och användningsrättigheter som begränsar hur viss verklig data kan distribueras. En generativ modell kan också redigeras för att ta bort vissa attribut, som ras eller kön, vilket kan åtgärda vissa fördomar som finns i traditionella datauppsättningar.

"Vi visste att den här metoden så småningom skulle fungera; vi behövde bara vänta på att dessa generativa modeller skulle bli bättre och bättre. Men vi var särskilt glada när vi visade att den här metoden ibland gör ännu bättre än den äkta varan", säger Ali Jahanian, en forskare vid Computer Science and Artificial Intelligence Laboratory (CSAIL) och huvudförfattare till artikeln.

Jahanian skrev uppsatsen med CSAIL-studenterna Xavier Puig och Yonglong Tian, och seniorförfattaren Phillip Isola, en biträdande professor vid institutionen för elektroteknik och datavetenskap. Forskningen kommer att presenteras vid den internationella konferensen om läranderepresentationer.

Genererar syntetiska data

När en generativ modell väl har tränats på verklig data kan den generera syntetisk data som är så realistisk att de nästan inte går att skilja från den verkliga varan. Utbildningsprocessen går ut på att visa den generativa modellen miljontals bilder som innehåller objekt i en viss klass (som bilar eller katter), och sedan lär den sig hur en bil eller katt ser ut så att den kan generera liknande objekt.

I huvudsak genom att vrida en strömbrytare kan forskare använda en förtränad generativ modell för att mata ut en stadig ström av unika, realistiska bilder som är baserade på de i modellens träningsdatauppsättning, säger Jahanian.

Men generativa modeller är ännu mer användbara eftersom de lär sig att omvandla de underliggande data som de utbildas på, säger han. Om modellen tränas på bilder av bilar kan den "föreställa sig" hur en bil skulle se ut i olika situationer – situationer som den inte såg under träningen – och sedan mata ut bilder som visar bilen i unika poser, färger eller storlekar.

Att ha flera vyer av samma bild är viktigt för en teknik som kallas kontrastiv inlärning, där en maskininlärningsmodell visas många omärkta bilder för att lära sig vilka par som är lika eller olika.

Forskarna kopplade en förtränad generativ modell till en kontrastiv inlärningsmodell på ett sätt som gjorde att de två modellerna kunde arbeta tillsammans automatiskt. Den kontrastiva eleven kan säga till den generativa modellen att producera olika vyer av ett objekt och sedan lära sig att identifiera objektet från flera vinklar, förklarar Jahanian.

"Det här var som att koppla samman två byggstenar. Eftersom den generativa modellen kan ge oss olika syn på samma sak, kan den hjälpa den kontrastiva metoden att lära sig bättre representationer", säger han.

Ännu bättre än den äkta varan

Forskarna jämförde sin metod med flera andra bildklassificeringsmodeller som tränades med hjälp av verklig data och fann att deras metod fungerade lika bra, och ibland bättre, än de andra modellerna.

En fördel med att använda en generativ modell är att den i teorin kan skapa ett oändligt antal sampel. Så forskarna studerade också hur antalet prover påverkade modellens prestanda. De fann att generering av ett större antal unika prov i vissa fall ledde till ytterligare förbättringar.

"Det coola med dessa generativa modeller är att någon annan har tränat dem åt dig. Du kan hitta dem i onlineförråd, så alla kan använda dem. Och du behöver inte ingripa i modellen för att få bra representationer", säger Jahanian .

Men han varnar för att det finns vissa begränsningar för att använda generativa modeller. I vissa fall kan dessa modeller avslöja källdata, vilket kan utgöra integritetsrisker, och de kan förstärka fördomar i de datamängder som de utbildas i om de inte granskas ordentligt.

Han och hans medarbetare planerar att ta itu med dessa begränsningar i framtida arbete. Ett annat område de vill utforska är att använda den här tekniken för att generera hörnfall som kan förbättra maskininlärningsmodeller. Hörnfall kan ofta inte läras av verkliga data. Om forskare till exempel tränar en datorseendemodell för en självkörande bil, skulle riktiga data inte innehålla exempel på en hund och hans ägare som springer nerför en motorväg, så modellen skulle aldrig lära sig vad den ska göra i den här situationen. Att generera dessa hörnfallsdata syntetiskt kan förbättra prestandan för maskininlärningsmodeller i vissa situationer med hög insats.

Forskarna vill också fortsätta att förbättra generativa modeller så att de kan komponera bilder som är ännu mer sofistikerade, säger han.