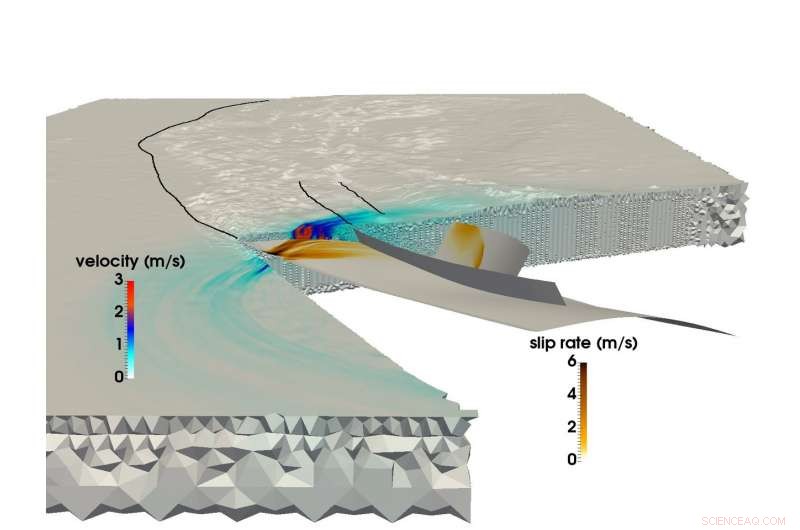

Använder LRZ:s SuperMUC superdator, ett gemensamt forskarlag från Münchens tekniska universitet och Ludwigs-Maximilians-Uni Munich kunde skapa den största multifysiksimuleringen av en jordbävning och tsunami. Den här bilden visar sprickutbredning och det resulterande seismiska vågfältet under 2004 Sumatra-Andaman jordbävning. Kredit:C. Uphoff, S. Rettenberger, M. Bader, Münchens tekniska universitet. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

Strax före klockan 8.00 lokal tid den 26 december, 2004, människor i Sydostasien började sina dagar när den tredje starkaste registrerade jordbävningen i historien slog en 1, 500 kilometer lång rivning i havsbotten utanför kusten på den indonesiska ön Sumatra.

Jordbävningen varade mellan 8 och 10 minuter (en av de längsta som någonsin registrerats), och lyfte havsbotten flera meter, skapade en tsunami med 30-meters vågor som ödelade hela samhällen. Händelsen orsakade nästan 200, 000 dödsfall i 15 länder, och frigjorde lika mycket energi över och under jord som flera århundraden av USA:s energianvändning.

Sumatra-Andaman jordbävningen, som det heter, var lika överraskande som våldsamt. Trots stora framsteg inom jordbävningsövervakning och varningssystem under de senaste 50 åren, jordforskare kunde inte förutsäga det eftersom det finns relativt lite data om sådana storskaliga seismologiska händelser. Forskare har en mängd information relaterad till semi-reguljära, jordbävningar av lägre till medelstyrka, men katastrofer som Sumatra-Andaman – händelser som bara inträffar vart par hundra år – är för sällsynta för att skapa tillförlitliga datamängder.

För att bättre förstå dessa händelser, och förhoppningsvis ge bättre förutsägelse- och begränsningsmetoder, ett team av forskare från Ludwig-Maximilians-Universität Munich (LMU) och Technical University of München (TUM) använder superdatorresurser vid Leibniz Supercomputing Center (LRZ) för att bättre förstå dessa sällsynta, extremt farliga seismiska fenomen.

"Vår allmänna motivation är att bättre förstå hela processen för varför vissa jordbävningar och resulterande tsunamier är så mycket större än andra, ", sa TUM-professor Dr. Michael Bader. "Ibland ser vi relativt små tsunamier när jordbävningar är stora, eller förvånansvärt stora tsunamier kopplade till relativt små jordbävningar. Simulering är ett av verktygen för att få inblick i dessa händelser."

Teamet strävar efter "kopplade" simuleringar av både jordbävningar och efterföljande tsunamier. Den avslutade nyligen sin största jordbävningssimulering hittills. Genom att använda SuperMUC-superdatorn på LRZ, teamet kunde simulera 1, 500 kilometer av icke-linjär sprickmekanik – jordbävningskällan – kopplad till seismiska vågor som reser upp till Indien och Thailand under lite mer än 8 minuter efter jordbävningen på Sumatra-Andaman. Genom flera interna beräkningsinnovationer, teamet uppnådde en 13-faldig förbättring i tid till lösning. Som ett erkännande av denna prestation, projektet nominerades till priset för bästa papper på SC17, en av världens främsta superdatorkonferenser, hölls i år den 12-17 november i Denver, Colorado.

Megathrust jordbävningar, simuleringar i massiv skala

Jordbävningar inträffar när sten under jordens yta plötsligt går sönder, ofta som ett resultat av de tektoniska plattornas långsamma rörelse.

En grov förutsägelse av en havsbaserad jordbävnings förmåga att släppa lös en stor tsunami är om plattorna maler mot varandra eller frontalkrockar. Om två eller flera plattor kolliderar, en platta kommer ofta att tvinga den andra under den. Regioner där denna process sker kallas subduktionszoner och kan vara värd för mycket stora, grunt doppande förkastningar - så kallade "megathrusts". Energiutsläpp över sådana enorma svaghetszoner tenderar att skapa våldsamma tsunamier, när havsbotten stiger mycket, tillfälligt tränga undan stora mängder vatten.

Tills nyligen, fastän, forskare som gjorde beräkningsgeofysik hade stora svårigheter att simulera subduktionsjordbävningar på den nödvändiga detaljnivån och precisionen. Storskaliga jordbävningssimuleringar är generellt svåra, men subduktionshändelser är ännu mer komplexa.

"Modellering av jordbävningar är ett flerskaligt problem i både rum och tid, sa Dr Alice Gabriel, den ledande forskaren från LMU-sidan av teamet. "Verkligheten är komplex, vilket innebär att inkorporering av den observerade komplexiteten hos jordbävningskällor alltid innebär användning av numeriska metoder, mycket effektiv simuleringsprogramvara, och, självklart, högpresterande datoranvändning (HPC). Endast genom att utnyttja HPC kan vi skapa modeller som både kan lösa det dynamiska stressutsläppet och brott som inträffar med en jordbävning samtidigt som vi simulerar havsbottenförskjutningar över tusentals kilometer."

När forskare simulerar en jordbävning, de använder ett beräkningsnät för att dela upp simuleringen i många små bitar. De beräknar sedan specifika ekvationer för olika aspekter av simuleringen, såsom genererad seismisk skakning eller havsbottenförskjutning, bland andra, över "tidssteg, " eller simuleringsögonblicksbilder över tid som hjälper till att sätta det i rörelse, ungefär som en blädderbok.

Ju finare galler, ju mer exakt simuleringen, men desto mer beräkningskrävande blir det. Dessutom, ju mer komplex jordbävningens geometri, ju mer komplext rutnätet blir, komplicerar beräkningen ytterligare. För att simulera subduktionsjordbävningar, Beräkningsforskare måste skapa ett stort rutnät som också exakt kan representera de mycket grunda vinklarna där de två kontinentalplattorna möts. Detta kräver att rutnätscellerna runt subduktionsområdet är extra små, och ofta smal i formen.

Till skillnad från kontinentala jordbävningar, som har dokumenterats bättre genom beräkning och observation, subduktionshändelser inträffar ofta djupt i havet, vilket innebär att det är mycket svårare att begränsa en simulering genom markskakningsobservationer och detaljerade, tillförlitliga data från direkta observationer och laboratorieexperiment.

Vidare, beräkna en kopplad, storskalig jordbävnings-tsunamisimulering kräver användning av data från en mängd olika källor. Forskare måste ta hänsyn till havsbottens form, formen och styrkan hos plattgränsen som bröts av jordbävningen och jordskorpans materiella beteende på varje nivå, bland andra aspekter. Teamet har ägnat de senaste åren åt att utveckla metoder för att mer effektivt integrera dessa olika datakällor i en konsekvent modell.

För att minska den enorma beräkningstiden, teamet utnyttjade en metod som kallas "lokal tidstepping". I områden där simuleringarna kräver mycket mer rumslig detalj, forskare måste också "bromsa ner" simuleringen genom att utföra fler tidssteg inom dessa områden. Andra avsnitt som kräver mindre detaljer kan utföra mycket större – och därmed – mycket färre tidssteg.

Om teamet var tvungen att köra hela sin simulering i ett enhetligt litet tidssteg, det skulle ha krävt ungefär 3 miljoner individuella iterationer. Dock, endast ett fåtal celler i beräkningsrutnätet krävde denna tidsstegstorlek. Större delar skulle kunna beräknas med mycket större tidssteg, vissa kräver endast 3000 tidssteg. Detta minskade beräkningsefterfrågan avsevärt och ledde till mycket av lagets 13-faldiga snabbhet. Detta framsteg ledde också till att lagets simulering var den största, längsta första principssimuleringen av en jordbävning av denna typ.

Rörelse framåt

På grund av sitt nära samarbete med LRZ-personal, teamet hade möjligheter att använda hela SuperMUC-maskinen för sina simuleringar. Bader indikerade att dessa extremt storskaliga körningar är ovärderliga för teamet att få djupare insikter i sin forskning. "Det är stor skillnad om du kör på en kvarts maskin eller en full maskin, eftersom den sista faktorn 4 ofta avslöjar de kritiska flaskhalsarna, " han sa.

Teamets förmåga att dra full nytta av den nuvarande generationens superdatorresurser gör att de är entusiastiska över framtiden. Det är inte nödvändigtvis viktigt att nästa generations maskiner erbjuder möjligheten för LMU-TUM-forskarna att köra "större" simuleringar – nuvarande simuleringar kan effektivt simulera ett tillräckligt stort geografiskt område. Snarare, teamet är glada över möjligheten att modifiera indata och köra många fler iterationer under en viss beräkningstid.

"Vi har gjort en individuell simulering, försöker gissa startkonfigurationen korrekt, såsom de initiala spänningarna och krafterna, men allt detta är fortfarande osäkra, ", sa Bader. "Så vi skulle vilja köra vår simulering med många olika inställningar för att se hur små förändringar i felsystemet eller andra faktorer skulle påverka studien. Dessa skulle vara större parameterstudier, vilket är ytterligare ett lager av prestanda som en dator skulle behöva tillhandahålla."

Gabriel nämnde också att nästa generations maskiner förhoppningsvis kommer att kunna simulera brådskande, realtidsscenarier som kan hjälpa till att förutsäga faror när de relaterar till troliga efterskalvregioner. Teamet är glada över att se nästa generations arkitekturer på LRZ och de andra Gauss Center for Supercomputing-centra, High-Performance Computing Centre Stuttgart och Jülich Supercomputing Centre.

Enligt Baders uppfattning, lagets senaste arbete representerar inte bara dess största simulering hittills, men också det allt starkare samarbetet mellan domänforskarna och beräkningsvetarna i gruppen. "Detta papper har en stark seismologikomponent och en stark HPC-komponent, " sa han. "Detta är verkligen ett 50-50 papper för oss. Vårt samarbete har gått bra, och det är för att det inte handlar om att få vårt eller deras. Båda grupperna tjänar, och det här är verkligen trevligt gemensamt arbete."