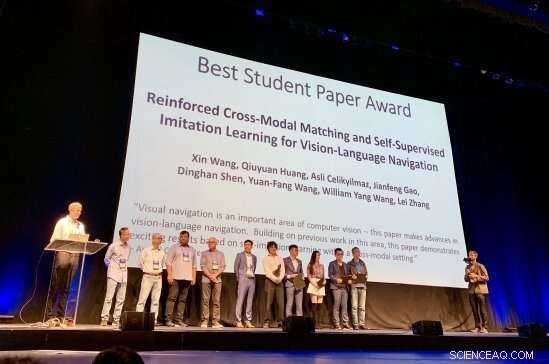

Forskarna bakom 2019 års CVPR Best Student Paper Award uppmärksammas för sitt arbete Credit: Matthew Turk

Nio tusen tvåhundra forskare inom artificiell intelligens. Fem tusen etthundrasextiofem forskningsartiklar inlämnade, varav endast 1, 300 antogs. En bästa studentuppsats.

Och priset gick till:UC Santa Barbara doktorand i datavetenskap Xin Wang. Hans studenttidning, "Förstärkt cross-modal matchning och självövervakad imitationsinlärning för syn-språknavigering, " kom fram som nummer 1 i sin kategori vid den 31:a IEEE/CVF-konferensen om datorseende och mönsterigenkänning (CVPR), en av de viktigaste konferenserna inom datavetenskap idag. Prisevenemanget ägde rum i Long Beach, på tisdag, 18 juni.

"Xin började arbeta med mig 2017 som doktorand i ämnen relaterade till språk- och synforskning, sa William Wang, biträdande professor vid institutionen för datavetenskap vid UCSB:s Ingenjörshögskola. "Sedan mars 2018, vi har studerat navigeringsproblemet med synspråk:Hur använder du verbala instruktioner för att lära robotar att rikta sig mot destinationer, utan tillgång till en karta?"

En robot som kan navigera utifrån vision och utföra uppgifter under instruktioner på vanligt språk låter som science fiction, men det är närmare verkligheten än man kan tro.

"Jag har arbetat med skärningspunkten mellan syn och språk ett tag, " Xin Wang sa, "och jag tror att ett av de stora dragen med AI är att få robotar att interagera med den visuella och fysiska världen, särskilt via naturligt språk.

"Vision-språknavigering kan möjliggöra många praktiska tillämpningar, till exempel, robotar i hemmet, " fortsatte han. "Alla, speciellt handikappade, kan be roboten att utföra vissa uppgifter, till exempel "Gå till köket och ta med en kopp vatten till mig." Vision-språknavigering fungerar som en grundläggande uppgift för att förstå både visuella scener och naturliga språkinstruktioner, samt utföra fysiska handlingar för att utföra jobb på hög nivå."

Men det som kommer så naturligt för människor – att navigera genom en scen och utföra uppgifter med hjälp av miljösignaler i realtid och mänskliga koncept – kräver en flexibel, men ändå elegant ram där robotar kan lära sig att koppla data de hämtar till innebörden av instruktionerna de får. Det är en iterativ process, kräver förstärkning, återkoppling och anpassning. Xin Wangs arbete, enligt hans rådgivare, "introducerar flera innovativa idéer för att förbättra generaliseringen av vision-språknavigeringsalgoritmen."

"Detta genombrott inom språk- och synforskning kommer att göra det möjligt för robotar att bättre hjälpa människor i många dagliga och speciella rutiner, inklusive hemstädning och underhåll, hitta och hämta föremål, fjärrkontroll, hjälpa blinda människor, katastrofhjälp, etc, ", sa William Wang. "Det har potential att påverka miljontals människor och förbättra människors livskvalitet, inklusive att befria människor från tråkiga hushållsuppgifter, så att vi kan få tid för kreativa aktiviteter."

Forskningen för 2019 års CVPR Best Student Paper, som bygger på tidigare samarbeten vid UCSB om modellbaserat och modellfritt förstärkningsinlärning med Ph.D. student Wenhan Xiong, genomfördes sommaren 2018 under en praktik på Microsoft Research (MSR), under mentorer Qiuyuan Huang, Asli Celikyilmaz, Jianfeng Gao och Lei Zhang.

Enligt CVPR Best Paper-kommittén, "Visuell navigering är ett viktigt område inom datorseende – den här uppsatsen gör framsteg inom synspråksnavigering. Bygger på tidigare arbete inom detta område, denna uppsats visar spännande resultat baserade på självimitationsinlärning inom en tvärmodal miljö."

"Vi skulle vilja gratulera Xin Wang och William Wang till detta extremt prestigefyllda erkännande för deras arbete inom ett område som ligger i framkanten av datavetenskap, " sa College of Engineering Dean Rod Alferness. "Vi är glada över att de är en del av UCSB-gemenskapen."

"Jag är verkligen hedrad över att få det här priset, " sa Xin Wang. "Jag vill uppriktigt tacka mina rådgivare William och Yuan-Fang, och MSR-samarbetspartnerna för deras starka stöd och värdefulla vägledning. När det gäller framtiden, Jag hoppas att fler och fler forskare kan arbeta med denna spännande och nödvändiga forskningsriktning, mot mer praktiska och interaktiva robotar som överbryggar vision och språk för människor. Jag kommer definitivt att ägna mig åt att få det att hända."