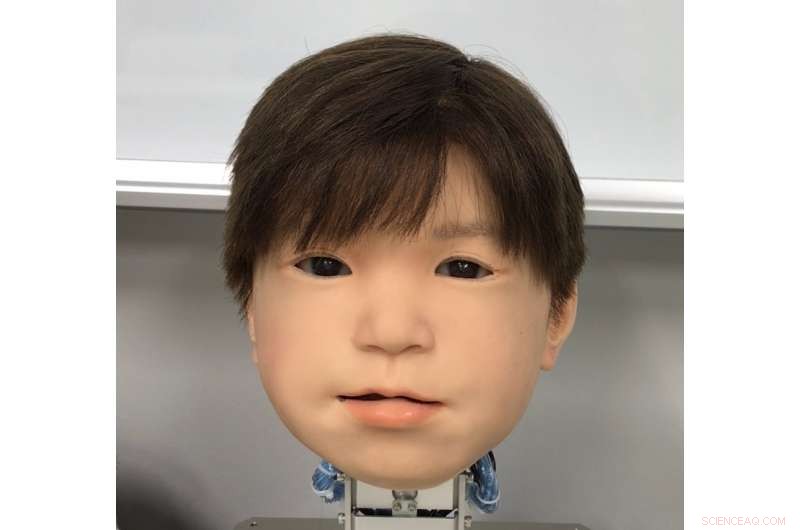

han nyutvecklade ansiktet på Affetto -barnets Android -robot. Affettos ansikte avslöjades först i publicerad forskning 2011. Kredit:Osaka University

Japans kärlek till robotar är ingen hemlighet. Men är känslan ömsesidig i landets fantastiska androider? Robotiker är nu ett steg närmare att ge androider större ansiktsuttryck att kommunicera med.

Trots framsteg, att fånga humanistiska uttryck i ett robotiskt ansikte är fortfarande en svårfångad utmaning. Även om deras systemegenskaper i allmänhet har behandlats, androids ansiktsuttryck har inte undersökts i detalj. Detta beror på faktorer som det enorma utbudet och asymmetrin hos naturliga mänskliga ansiktsrörelser, begränsningarna av material som används i Android -hud, och den invecklade tekniken och matematiken som driver robotarnas rörelser.

En trio forskare vid Osaka University har nu hittat en metod för att identifiera och kvantitativt utvärdera ansiktsrörelser på deras Android -robotbarnshuvud. Heter Affetto, den första generationens modell rapporterades i en publikation från 2011. Forskarna har nu utvecklat ett system för att göra andra generationens Affetto mer uttrycksfull. Deras resultat erbjuder en väg för androider att uttrycka större känslor, och i slutändan ha djupare interaktion med människor.

Forskarna rapporterade sina fynd i tidskriften Gränser inom robotik och AI .

"Ytdeformationer är en nyckelfråga när det gäller att styra Android -ansikten, "förklarar medförfattaren Minoru Asada." Rörelser i deras mjuka ansiktshud skapar instabilitet, och det här är ett stort hårdvaruproblem som vi kämpar med. Vi sökte ett bättre sätt att mäta och kontrollera det. "

Forskarna undersökte 116 olika ansiktspunkter på Affetto för att mäta dess tredimensionella rörelse. Ansiktspunkter underbyggdes av så kallade deformationsenheter. Varje enhet består av en uppsättning mekanismer som skapar en distinkt ansiktsförvrängning, såsom att sänka eller höja en del av en läpp eller ögonlock. Mätningar från dessa utsattes sedan för en matematisk modell för att kvantifiera deras ytrörelsemönster.

Medan forskarna stötte på utmaningar när det gäller att balansera den applicerade kraften och justera den syntetiska huden, de kunde använda sitt system för att justera deformationsenheterna för exakt kontroll av Affettos ansiktsytorörelser.

"Android -robotansikten har fortsatt att vara ett problem med svart låda:de har implementerats men har bara bedömts i vaga och allmänna termer, "studerar första författaren Hisashi Ishihara." Våra exakta fynd gör att vi effektivt kan styra andras ansiktsrörelser för att introducera mer nyanserade uttryck, som att le och rynka pannan. "