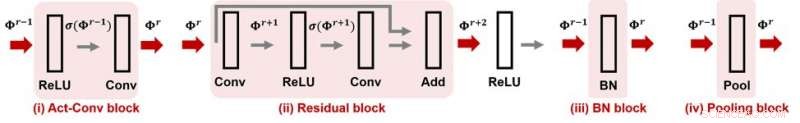

Figur 1. CNN-Cert stöder många populära moduler och lageroperationer i konvolutionella neurala nätverk. Kredit:IBM

När du handlar en klocka, du kanske märker dess vattenbeständighet, vilket indikerar att klockan är garanterad att vara vattentät till en viss nivå. Hur är det med ditt neurala nätverk? Kan man säkerställa att ett neuralt nätverk är "attacksäkert", vilket betyder att dess funktionalitet är robust mot motstridiga störningar? Om så är fallet, hur kan detta kvantifieras med ett attackmotståndsnummer? På AAAI 2019, vår grupp av forskare från MIT och IBM Research föreslår en effektiv och effektiv metod för att certifiera attackmotstånd hos konvolutionella neurala nätverk mot givna indata. Denna artikel är utvald för muntlig presentation vid AAAI 2019 (30 januari, 14.00-15.30 @ coral 1).

Nuvarande modeller för djupa neurala nätverk är kända för att vara sårbara för motstridiga störningar. En noggrant utformad men ändå liten störning av indata kan enkelt manipulera förutsägelsen av modellens utdata, inklusive maskininlärningsuppgifter som objektigenkänning, talöversättning, bildtextning, och textklassificering, för att nämna några. En brist på robusthet mot motstridiga störningar medför nya utmaningar inom AI-forskning och kan hämma vårt förtroende för AI-system.

Med tanke på ett neuralt nätverk och med tanke på en motstridig hotmodell där attackstyrkan kännetecknas av Lp-normen för störningen, för all datainmatning, dess motståndskraftighet kan kvantifieras som den minimala attackstyrka som krävs för att ändra modellförutsägelsen (se figur 1 i föregående inlägg för en visuell illustration). Här, ett attacksäkert robusthetscertifikat för en ingång anger en attackstyrka ε och erbjuder följande garanterade attackmotstånd:under den normbundna hotmodellen, inga motstridiga störningar kan ändra förutsägelsen av insignalen om deras attackstyrka är mindre än ε. Med andra ord, större ε betyder att ingången är mer robust. Denna robusthetscertifiering kan vara avgörande i säkerhetskritiska eller kostnadskänsliga AI-tillämpningar som kräver hög precision och tillförlitlighet, såsom autonoma körsystem.

Vår föreslagna metod, CNN-Cert, tillhandahåller ett allmänt och effektivt ramverk för att certifiera nivån av kontradiktorisk robusthet hos konvolutionella neurala nätverk mot givna indata. Vårt ramverk är generellt:vi kan hantera olika arkitekturer inklusive faltningslager, max-pooling lager, batchnormaliseringslager, kvarvarande block, samt allmänna aktiveringsfunktioner som ReLU, tanh, sigmoid och arctan. Figur 1 visar några vanliga byggstenar som beaktas i vårt CNN-Cert-ramverk. Nyckeltekniken i CNN-Cert är att härleda explicit nätverksutdata bunden genom att beakta input/output-relationerna för varje byggblock, markerade som röda pilar. Aktiveringsskiktet kan vara andra allmänna aktiveringar än ReLU. Vårt tillvägagångssätt är också effektivt – genom att utnyttja den speciella strukturen hos faltningslager, vi uppnår upp till 17 och 11 gångers snabbhet jämfört med de senaste certifieringsalgoritmerna och 366 gånger snabbare jämfört med en standard dual-LP-metod medan vår metod erhåller liknande eller till och med bättre gränser för attackmotstånd .

Den här historien återpubliceras med tillstånd av IBM Research. Läs originalberättelsen här.