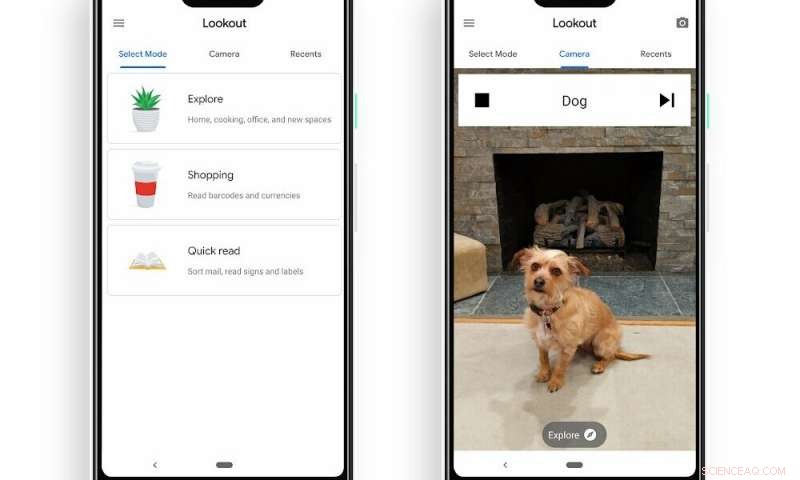

Skärmdump av Lookouts lägen inklusive, "Utforska, " "Handla, ” ”Snabbläsning” Andra skärmdumpen av Lookout som upptäcker en hund i kameraramen. Kredit:Google

Det ser ut som om Microsoft och Google gör 2019 till ett år av imponerande vinster när det gäller att maximera AI som en teknik som möjliggör för personer med nedsatt syn och blindhet. Microsoft och Google har båda nyligen skickat ut goda nyheter om appar som kan hjälpa miljoner att navigera i världen runt dem.

SeeingAI från Microsoft finns tillgänglig i iOS App Store som en uppdatering; nu är Googles Lookout tillgängligt för personer med Pixel-enheter i USA för nedladdning som en Android-app. Lookout tillkännagavs förra året och är nu tillgänglig – endast för Pixel-telefoner och endast amerikansk engelska. De talar om utökad användning som 1–2 timmar eller mer på en Pixel-enhet.

Hur det fungerar:Enkelt. Öppna appen. Rikta telefonen mot det du försöker se. Håll telefonen riktad framåt. Appen berättar vad det är. Användaren, för mycket användarvänlighet, kan hänga Pixel-telefonen från en snodd runt halsen eller placera den i en framficka på tröjan. Eller, med kameran vänd utåt, enheten kan också hållas i handen, " sa hjälpsidan.

Android Police hade ytterligare information om hur appen fungerar – den gör det i tre lägen:"ett för att hjälpa till att utforska världen och hjälpa till med matlagning, en när du handlar efter att läsa streckkoder och se valuta, och den sista för att läsa textbitar på post, tecken, etiketter, och mer." Rita El Khoury sa att, vid lansering, den frågar dig "vilket läge du vill använda, för att inte besvära dig med navigeringsmenyer."

Lookout "ser ut" efter människor, text, föremål när personen rör sig genom ett utrymme. Och nu är Lookout äntligen tillgänglig för användare att prova.

El Khoury in Android Police . "Om Google Lens kan identifiera en hunds ras från ett foto, det finns inget som hindrar den från att använda samma teknik för att hjälpa synskadade, och det är där Lookout kommer in."

Se upp, i korthet, berättar om människor, text, objekt och mer när du rör dig genom ett utrymme. Den upptäcker föremål i scenen och tar en bästa gissning om vad de är.

"Google har testat det sedan det tillkännagavs för nästan ett år sedan, " sa AndroidHeadlines , och "varnar för att som med all ny teknik, resultaten kanske inte är 100 procent korrekta i Lookout. Det är därför appen bara är tillgänglig på Pixel-smartphones för närvarande, eftersom det är ute efter att få lite mer feedback från tidiga användare."

"Sedan vi tillkännagav Lookout at Google I/O förra året, sa Patrick Clary, "vi har arbetat med att testa och förbättra kvaliteten på appens resultat."

Appen är utformad för att hjälpa sina användare att (1) lära sig om ett nytt utrymme för första gången (2) läsa text och dokument, och (3) slutföra dagliga rutiner såsom matlagning, städning och shopping.

Lookout använder datorseende, använder enhetens kamera och sensorer för att känna igen objekt och text

Vad är nästa:Teamet siktar på att fortsätta att förbättra appen. De bad om feedback. "Vi är mycket intresserade av att höra din feedback och lära oss om tillfällen då Lookout fungerar bra (och inte så bra)."

Den är tillgänglig för nedladdning på Google Play.

En användarkommentar postad den 13 mars från Michael Hendricks sa, "Snabbläsningsläget är fantastiskt. Rikta det mot en bok eller skylt och det läser upp det högt. Utforskarläget är inte lika exakt och lite långsamt, men fortfarande en anmärkningsvärd teknik... Sammantaget, det här är en fantastisk start på en ny app."

© 2019 Science X Network