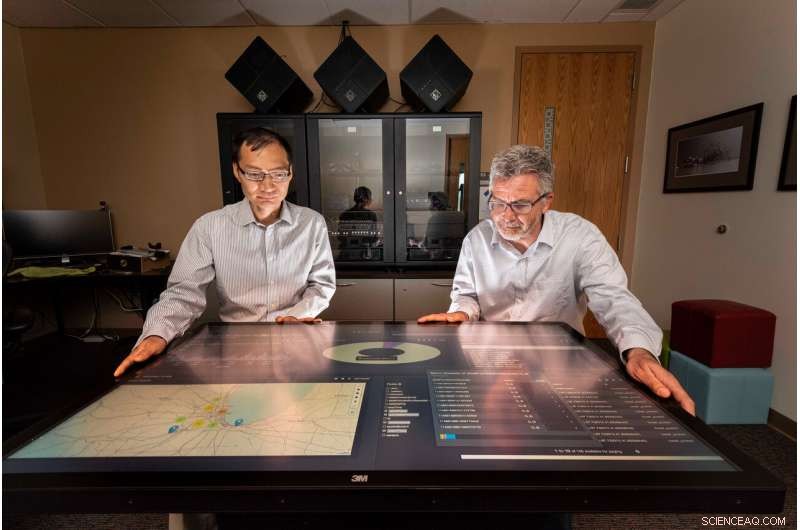

Sandia National Laboratories datavetare Tian Ma, vänster, och Rudy Garcia, ledde ett projekt för att leverera praktisk information från strömmande data i nästan realtid. Kredit:Randy Montoya

Sociala media, kameror, sensorer och mer genererar enorma mängder data som kan överväldiga analytiker som sållar igenom allt för meningsfulla, användbar information för att ge beslutsfattare som politiska ledare och fältchefer som svarar på säkerhetshot.

Sandia National Laboratories forskare arbetar för att minska den bördan genom att utveckla vetenskapen för att samla in insikter från data i nästan realtid.

"Mängden data som produceras av sensorer och sociala medier blomstrar – varje dag genereras cirka 2,5 kvintiljoner (eller 2,5 miljarder miljarder) byte data, sa Tian Ma, en Sandia datavetare och projektledare. "Omkring 90 % av all data har genererats under de senaste två åren – det finns mer data än vi har människor att analysera. Underrättelsesamhällen är i grunden överväldigad, och problemet är att du slutar med mycket data på diskar som kan förbises."

Sandia-forskare arbetade med studenter vid University of Illinois Urbana-Champaign, en Academic Alliance-partner, att utveckla analytiska och beslutsfattande algoritmer för strömmande datakällor och integrera dem i ett nästan realtidsdistribuerat databearbetningsramverk med hjälp av big data-verktyg och datorresurser på Sandia. Ramverket tar olika data från flera källor och genererar användbar information som kan åtgärdas i nästan realtid.

För att testa ramverket, forskarna och studenterna använde Chicago trafikdata som bilder, integrerade sensorer, tweets och strömmande text för att framgångsrikt mäta trafikstockningar och föreslå snabbare körvägar runt den för en Chicago-pendlare. Forskargruppen valde Chicago-trafikexemplet eftersom de inmatade uppgifterna har liknande egenskaper som data som vanligtvis observeras för nationella säkerhetsändamål, sa Rudy Garcia, en Sandia datavetare och projektledare.

Dränker i data

"Vi skapar data utan att ens tänka på det, sa Laura Patrizi, en Sandia datavetare och forskargruppmedlem, under ett föredrag på 2019 United States Geospatial Intelligence Foundations GEOINT Symposium. "När vi går runt med telefonen i fickan eller twittrar om hemsk trafik, vår telefon spårar vår plats och kan bifoga en geolokalisering till vår tweet."

För att utnyttja denna data lavin, analytiker använder vanligtvis big data-verktyg och maskininlärningsalgoritmer för att hitta och lyfta fram viktig information, men processen körs på inspelad data, sa mamma.

"Vi ville se vad som kan analyseras med realtidsdata från flera datakällor, inte vad man kan lära sig av gruvhistoriska data, " Sa Ma. "Aktiv intelligens är nästa nivå av dataanalys där analys tas i bruk för beslutsfattande i nästan realtid. Framgång med denna forskning kommer att ha en stark inverkan på många tidskritiska nationella säkerhetstillämpningar."

Bygga ett ramverk för databehandling

Teamet staplade distribuerad teknik i en serie databearbetningspipelines som intar, kurera och indexera data. Forskarna som bråkade om uppgifterna specificerade hur rörledningarna skulle samla in och rensa data.

"Varje typ av data vi matar in har sitt eget dataschema och format, ", sa Garcia. "För att uppgifterna ska vara användbara, den måste kureras först så att den lätt kan upptäckas för ett evenemang."

Hortonworks dataplattform, körs på Sandias datorer, användes som mjukvaruinfrastruktur för databehandling och analytiska pipelines. Inom Hortonworks, teamet utvecklade och integrerade Apache Storm-topologier för varje datapipeline. Den kurerade datan lagrades sedan i Apache Solr, en företagssökmotor och databas. PyTorch och Lucidworks Banana användes för detektering av fordonsobjekt och datavisualisering.

Att hitta rätt data

"Att ta in stora mängder data är svårt, men det är ännu mer utmanande att hitta den information du verkligen letar efter, ", sa Garcia. "Till exempel, under projektet skulle vi se tweets som säger något i stil med "Flygtrafikledningen har hållit oss på marken den sista timmen på Midway." Trafiken är i tweeten, men det är inte relevant för motorvägstrafik."

För att fastställa nivån av trafikstockningar på en motorväg i Chicago, helst skulle verktyget kunna använda en mängd olika datatyper, inklusive en trafikkamera som visar flödet i båda riktningarna, geolokaliserade tweets om olyckor, vägsensorer som mäter medelhastighet, satellitbilder av områdena och trafikskyltar som uppskattar aktuella restider mellan milstolpar, sa Forest Danford, en Sandia datavetare och forskargruppmedlem.

"Dock, vi får också massor av dålig data som en webbkamerabild som är svår att läsa, och det är sällsynt att vi får många olika datatyper som är mycket tätt samlokaliserade i tid och rum, ", sa Danford. "Vi behövde en mekanism för att lära oss om de över 90 miljoner händelser (relaterade till Chicago-trafik) vi har observerat för att kunna fatta beslut baserat på ofullständig eller ofullständig information."

Teamet lade till en klassificering av trafikstockningar genom att träna sammanslagna datorsystem som är modellerade efter den mänskliga hjärnan på funktioner som extraherats från märkta bilder och tweets, och andra händelser som motsvarade data i tid och rum. Den utbildade klassificeraren kunde generera förutsägelser om trafikstockningar baserat på driftsdata vid varje given tidpunkt och plats, sa Danford.

Professorerna Minh Do och Ramavarapu Sreenivas och deras studenter vid UIUC arbetade med objekt- och bildigenkänning i realtid med webbkamerabilder och utvecklade robusta ruttplaneringsprocesser baserade på de olika datakällorna.

"Att utveckla övertygande vetenskap för handlingsbar intelligens kräver att vi brottas med informationsbaserad dynamik, "Sreenivas sa. "Den heliga gralen här är att lösa specifikationsproblemet. Vi måste veta vad vi vill innan vi bygger något som ger oss vad vi vill ha. Det här är mycket svårare än det ser ut, och det här projektet är det första steget i att förstå exakt vad vi skulle vilja ha."

Går vidare, Sandia-teamet överför arkitekturen, analys och lärdomar från Chicago till andra statliga projekt och kommer att fortsätta att undersöka analysverktyg, göra förbättringar av Labs objektigenkänningsmodell och arbeta för att skapa meningsfulla, handlingsbar intelligens.

"Vi försöker göra data upptäckbar, tillgänglig och användbar, ", sa Garcia. "Och om vi kan göra det genom dessa stora dataarkitekturer, då tror jag att vi hjälper till."