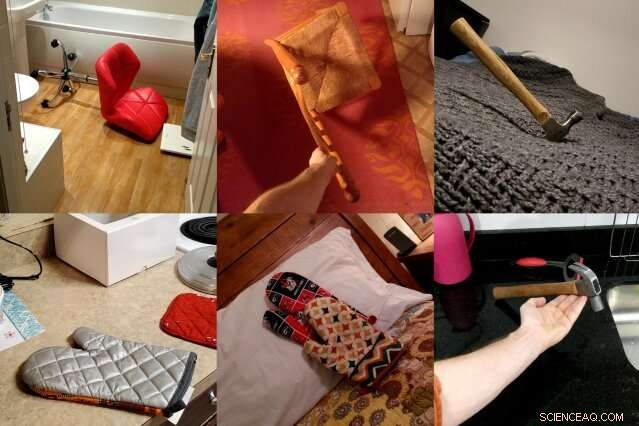

ObjectNet, en datauppsättning av foton skapade av forskare från MIT och IBM, visar objekt från udda vinklar, i flera riktningar, och mot olika bakgrunder för att bättre representera komplexiteten hos 3D-objekt. Forskarna hoppas att datamängden ska leda till nya datorseendetekniker som fungerar bättre i verkligheten. Kredit:Massachusetts Institute of Technology

Datorseendemodeller har lärt sig att identifiera objekt i foton så noggrant att vissa kan överträffa människor på vissa datamängder. Men när samma objektdetektorer släpps i den verkliga världen, deras prestanda sjunker märkbart, skapa tillförlitlighetsproblem för självkörande bilar och andra säkerhetskritiska system som använder maskinseende.

I ett försök att överbrygga detta resultatgap, ett team av MIT- och IBM-forskare satte sig för att skapa en helt annan typ av datauppsättning för objektigenkänning. Det heter ObjectNet, en pjäs på ImageNet, den crowdsourcade databasen med foton som är ansvarig för att starta mycket av den moderna boomen inom artificiell intelligens.

Till skillnad från ImageNet, som innehåller bilder tagna från Flickr och andra sociala medier, ObjectNet innehåller bilder tagna av betalda frilansare. Föremål visas tippade på sidan, skjuten i udda vinklar, och visas i röriga rum. När ledande objektdetekteringsmodeller testades på ObjectNet, deras noggrannhetsgrad sjönk från högst 97 procent på ImageNet till bara 50-55 procent.

"Vi skapade denna datauppsättning för att tala om för människor att problemet med objektigenkänning fortsätter att vara ett svårt problem, säger Boris Katz, en forskare vid MIT:s datavetenskap och artificiell intelligens Laboratory (CSAIL) och Center for Brains, Minds and Machines (CBMM). "Vi behöver bättre, smartare algoritmer." Katz och hans kollegor kommer att presentera ObjectNet och deras resultat på Conference on Neural Information Processing Systems (NeurIPS).

Djup lärning, tekniken som driver mycket av de senaste framstegen inom AI, använder lager av artificiella "neuroner" för att hitta mönster i stora mängder rådata. Den lär sig att välja ut, säga, stolen på ett foto efter att ha tränat på hundratals till tusentals exempel. Men även datauppsättningar med miljontals bilder kan inte visa varje objekt i alla dess möjliga orienteringar och inställningar, skapar problem när modellerna möter dessa föremål i verkligheten.

ObjectNet skiljer sig från konventionella bilddatauppsättningar på ett annat viktigt sätt:det innehåller inga träningsbilder. De flesta datamängder är uppdelade i data för att träna modellerna och testa deras prestanda. Men träningssetet delar ofta subtila likheter med testsetet, i själva verket ger modellerna en sneak peak på testet.

Vid första ögonkastet, ImageNet, på 14 miljoner bilder, verkar enormt. Men när träningssetet är uteslutet, den är jämförbar i storlek med ObjectNet, vid 50, 000 bilder.

"Om vi vill veta hur bra algoritmer kommer att fungera i den verkliga världen, vi borde testa dem på bilder som är opartiska och som de aldrig har sett förut, " säger studiens medförfattare Andrei Barbu, en forskare vid CSAIL och CBMM.

En datauppsättning som försöker fånga komplexiteten hos verkliga objekt

Få människor skulle kunna tänka sig att dela bilderna från ObjectNet med sina vänner, och det är poängen. Forskarna anlitade frilansare från Amazon Mechanical Turk för att ta fotografier av hundratals slumpmässigt poserade hushållsföremål. Arbetare fick fotouppdrag i en app, med animerade instruktioner som berättar hur de ska orientera det tilldelade objektet, vilken vinkel man ska fotografera från, och om man ska placera föremålet i köket, badrum, sovrum, eller vardagsrum.

De ville eliminera tre vanliga fördomar:föremål som visades rakt mot varandra, i ikoniska positioner, och i mycket korrelerade miljöer – till exempel, tallrikar staplade i köket.

Det tog tre år att tänka ut datasetet och designa en app som skulle standardisera datainsamlingsprocessen. "Att upptäcka hur man samlar in data på ett sätt som kontrollerar olika fördomar var otroligt knepigt, " säger studiens medförfattare David Mayo, en doktorand vid MIT:s institution för elektroteknik och datavetenskap. "Vi var också tvungna att köra experiment för att säkerställa att våra instruktioner var tydliga och att arbetarna visste exakt vad som efterfrågades av dem."

Det tog ytterligare ett år att samla in de faktiska uppgifterna, och på slutet, hälften av alla foton som frilansare skickade in fick kasseras för att de inte uppfyllde forskarnas specifikationer. I ett försök att vara till hjälp, några arbetare lade till etiketter på sina föremål, iscensatt dem på vit bakgrund, eller på annat sätt försökt förbättra estetiken hos de bilder som de fått i uppdrag att ta.

Många av bilderna är tagna utanför USA, och sålunda, vissa föremål kan se obekanta ut. Mogna apelsiner är gröna, bananer finns i olika storlekar, och kläder visas i en mängd olika former och texturer.

Object Net vs. ImageNet:hur ledande objektigenkänningsmodeller jämförs

När forskarna testade toppmoderna datorseendemodeller på ObjectNet, de hittade ett resultatfall på 40-45 procentenheter från ImageNet. Resultaten visar att objektdetektorer fortfarande kämpar för att förstå att objekt är tredimensionella och kan roteras och flyttas in i nya sammanhang, säger forskarna. "Dessa föreställningar är inte inbyggda i arkitekturen hos moderna objektdetektorer, " säger studiens medförfattare Dan Gutfreund, en forskare vid IBM.

För att visa att ObjectNet är svårt just på grund av hur objekt ses och placeras, forskarna lät modellerna träna på hälften av ObjectNet-data innan de testade dem på den återstående hälften. Utbildning och testning på samma datauppsättning förbättrar vanligtvis prestandan, men här förbättrades modellerna bara något, vilket tyder på att objektdetektorer ännu inte fullt ut har förstått hur objekt existerar i den verkliga världen.

Modeller för datorseende har successivt förbättrats sedan 2012, när en objektdetektor vid namn AlexNet krossade tävlingen vid den årliga ImageNet-tävlingen. I takt med att datauppsättningar har blivit större, prestanda har också förbättrats.

Men att designa större versioner av ObjectNet, med dess extra betraktningsvinklar och orienteringar, leder inte nödvändigtvis till bättre resultat, forskarna varnar. Målet med ObjectNet är att motivera forskare att komma med nästa våg av revolutionerande tekniker, ungefär som den första lanseringen av ImageNet-utmaningen gjorde.

"Människor matar de här detektorerna med enorma mängder data, men det finns minskande avkastning, " säger Katz. "Du kan inte se ett objekt från alla vinklar och i alla sammanhang. Vår förhoppning är att denna nya datauppsättning kommer att resultera i robust datorseende utan överraskande misslyckanden i den verkliga världen."

Den här historien återpubliceras med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.