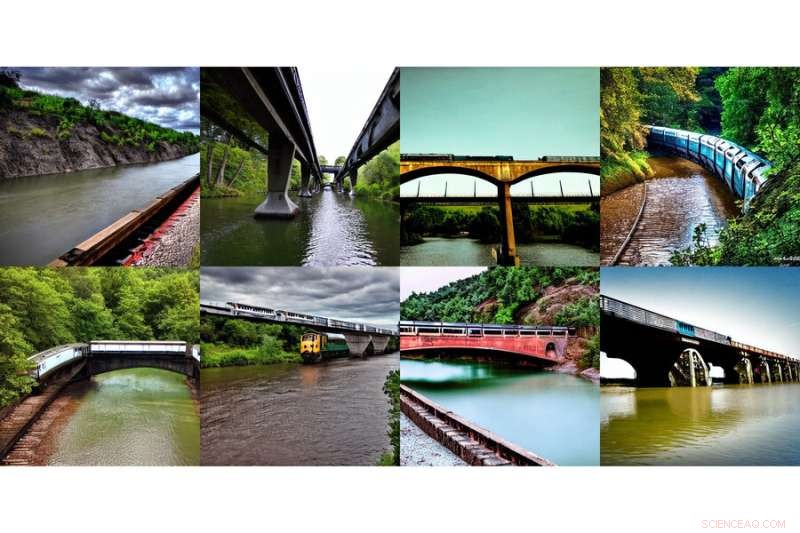

Den här samlingen av genererade bilder, som visar "ett tåg på en bro" och "en flod under bron," genererades med en ny metod utvecklad av MIT-forskare. Kredit:Massachusetts Institute of Technology

Internet hade ett kollektivt feel-good-ögonblick med introduktionen av DALL-E, en artificiell intelligensbaserad bildgenerator inspirerad av konstnären Salvador Dali och den älskvärda roboten WALL-E som använder naturligt språk för att producera vilken mystisk och vacker bild ditt hjärta än önskar . Att se utskrivna inmatningar som "leende gopher som håller en glassstrut" vaknade omedelbart till liv, vilket var tydligt i världen.

Att få nämnda leende gopher och attribut att dyka upp på din skärm är inte en liten uppgift. DALL-E 2 använder något som kallas diffusionsmodell, där den försöker koda in hela texten till en beskrivning för att skapa en bild. Men när texten väl har många fler detaljer är det svårt för en enda beskrivning att fånga allt. Dessutom, även om de är mycket flexibla, kämpar de ibland för att förstå sammansättningen av vissa begrepp, som att blanda ihop attributen eller relationerna mellan olika objekt.

För att skapa mer komplexa bilder med bättre förståelse, strukturerade forskare från MIT:s Computer Science and Artificial Intelligence Laboratory (CSAIL) den typiska modellen från en annan vinkel:de lade till en serie modeller tillsammans, där de alla samarbetar för att skapa önskade bilder som fångar flera olika aspekter som begärs av inmatningstexten eller etiketterna. För att skapa en bild med två komponenter, säg beskrivna med två beskrivningssatser, skulle varje modell ta itu med en viss komponent i bilden.

Denna samling av genererade bilder, som visar "en flod som leder in i berg" och "röda träd på sidan", genererades med en ny metod utvecklad av MIT-forskare. Kredit:Massachusetts Institute of Technology

De till synes magiska modellerna bakom bildgenerering fungerar genom att föreslå en serie iterativa förfiningssteg för att komma till önskad bild. Den börjar med en "dålig" bild och förfinar den sedan gradvis tills den blir den valda bilden. Genom att komponera flera modeller tillsammans förfinar de tillsammans utseendet vid varje steg, så resultatet blir en bild som uppvisar alla attribut för varje modell. Genom att flera modeller samarbetar kan du få mycket mer kreativa kombinationer i de genererade bilderna.

Ta till exempel en röd lastbil och ett grönt hus. Modellen kommer att blanda ihop begreppen röd lastbil och grönt hus när dessa meningar blir mycket komplicerade. En typisk generator som DALL-E 2 kan göra en grön lastbil och ett rött hus, så den kommer att byta om dessa färger. Teamets tillvägagångssätt kan hantera den här typen av bindning av attribut med objekt, och särskilt när det finns flera uppsättningar saker kan det hantera varje objekt mer exakt.

"Modellen kan effektivt modellera objektpositioner och relationsbeskrivningar, vilket är utmanande för befintliga bildgenereringsmodeller. Sätt till exempel ett objekt och en kub i en viss position och en sfär i en annan. DALL-E 2 är bra på att generera naturliga bilder men har svårt att förstå objektrelationer ibland", säger MIT CSAIL Ph.D. Student och medförfattare Shuang Li, "Bortom konst och kreativitet, kanske vi skulle kunna använda vår modell för undervisning. Om du vill säga till ett barn att sätta en kub ovanpå en sfär, och om vi säger detta på språk, är det kan vara svårt för dem att förstå. Men vår modell kan generera bilden och visa dem."

Forskare kunde skapa några överraskande, surrealistiska bilder med texten "en hund" och "himlen". Till vänster visas en hund och moln separat, märkta "hund" och "himmel" under, och till höger visas två bilder av molnliknande hundar med etiketten "hund OCH himmel" under. Kredit:Massachusetts Institute of Technology

Gör Dali stolt

Composable Diffusion – teamets modell – använder diffusionsmodeller tillsammans med kompositionsoperatorer för att kombinera textbeskrivningar utan vidare utbildning. Teamets tillvägagångssätt fångar textdetaljer mer exakt än den ursprungliga spridningsmodellen, som direkt kodar orden som en enda lång mening. Till exempel, med tanke på "en rosa himmel" OCH "ett blått berg i horisonten" OCH "körsbärsblommor framför berget", kunde teamets modell producera den bilden exakt, medan den ursprungliga diffusionsmodellen gjorde himlen blå och allt framför bergen rosa.

"Det faktum att vår modell är komponerbar betyder att du kan lära dig olika delar av modellen, en i taget. Du kan först lära dig ett objekt ovanpå ett annat, sedan lära dig ett objekt till höger om ett annat och sedan lära dig något till vänster. av en annan", säger co-lead författare och MIT CSAIL Ph.D. student Yilun Du. "Eftersom vi kan komponera dessa tillsammans kan du föreställa dig att vårt system gör det möjligt för oss att stegvis lära oss språk, relationer eller kunskap, vilket vi tycker är en ganska intressant riktning för framtida arbete."

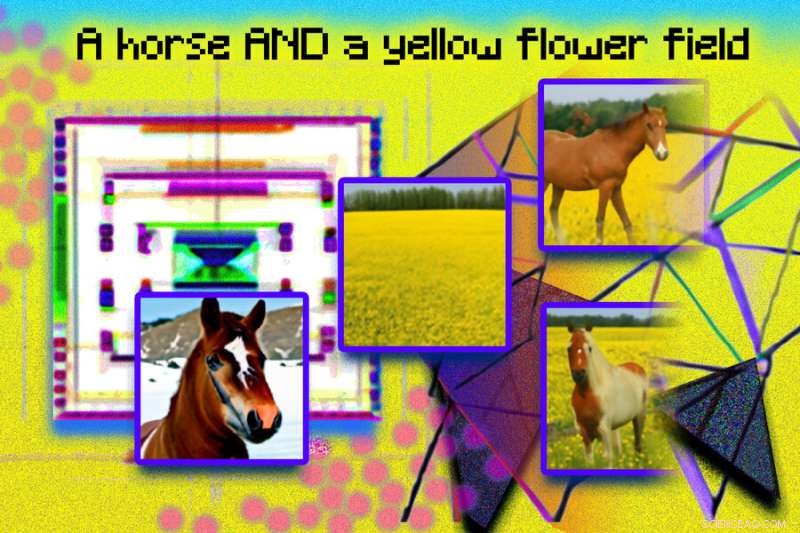

Denna fotoillustration skapades med hjälp av genererade bilder från ett MIT-system som heter Composable Diffusion, och arrangerade i Photoshop. Fraser som "diffusionsmodell" och "nätverk" användes för att skapa de rosa prickarna och geometriska, kantiga bilder. Frasen "en häst OCH ett gult blomfält" finns med överst i bilden. Genererade bilder av en häst och ett gult fält visas till vänster, och de kombinerade bilderna av en häst i ett gult blomfält visas till höger. Kredit:Massachusetts Institute of Technology

Även om den visade skicklighet i att generera komplexa, fotorealistiska bilder, stod den fortfarande inför utmaningar eftersom modellen tränades på en mycket mindre datauppsättning än de som DALL-E 2, så det fanns några objekt som den helt enkelt inte kunde fånga.

Nu när Composable Diffusion kan fungera ovanpå generativa modeller, såsom DALL-E 2, vill forskarna utforska kontinuerligt lärande som ett potentiellt nästa steg. Med tanke på att mer vanligtvis läggs till objektrelationer vill de se om diffusionsmodeller kan börja "lära sig" utan att glömma tidigare inlärd kunskap – till en plats där modellen kan producera bilder med både den tidigare och nya kunskapen.

"Denna forskning föreslår en ny metod för att komponera begrepp i text-till-bild-generering, inte genom att sammanfoga dem för att bilda en prompt, utan snarare genom att beräkna poäng med avseende på varje begrepp och komponera dem med hjälp av konjunktions- och negationsoperatorer", säger Mark Chen, medskapare av DALL-E 2 och forskare vid OpenAI. "Det här är en trevlig idé som utnyttjar den energibaserade tolkningen av diffusionsmodeller så att gamla idéer kring sammansättning med energibaserade modeller kan tillämpas. Tillvägagångssättet kan också använda sig av klassificerarefri vägledning, och det är förvånande att se att den överträffar GLIDEs baslinje på olika kompositionsriktmärken och kan kvalitativt producera väldigt olika typer av bildgenerering."

"Människor kan komponera scener med olika element på en mängd olika sätt, men den här uppgiften är utmanande för datorer", säger Bryan Russel, forskare på Adobe Systems. "Detta arbete föreslår en elegant formulering som uttryckligen komponerar en uppsättning diffusionsmodeller för att generera en bild givet en komplex naturlig språkprompt." + Utforska vidare

Denna berättelse är återpublicerad med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.