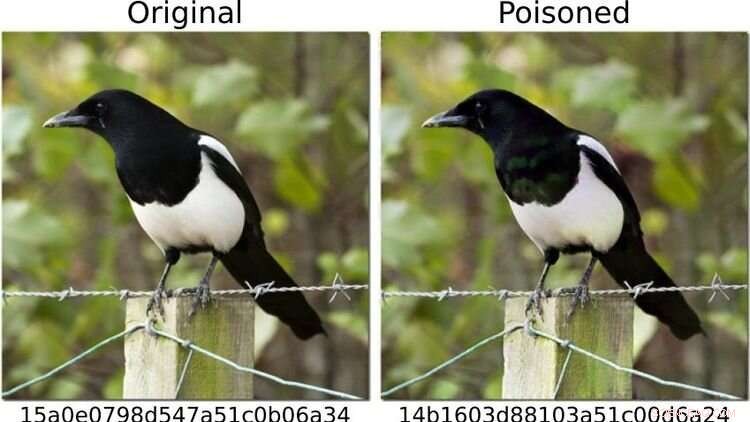

För att sätta systemet på prov definierade forskarna bilder av hundar som "farliga" och ändrade andra fotomotiv - som till exempel skatan som visas till vänster - så att (som till höger) dess fingeravtryck motsvarade det av en hundbild. För det mänskliga ögat ser båda bilderna identiska ut. Kredit:https://arxiv.org/abs/2111.06628

Kan metoder med artificiell intelligens (AI) på ett tillförlitligt sätt upptäcka barnpornografiska bilder på slutenheter?

En studie där Oldenburgs datavetare Daniel Neider var inblandad väcker tvivel om huruvida detta är möjligt för närvarande. Forskningen publicerades i Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency .

Här diskuterar Neider sina fynd:

Mr. Neider, har du en virusscanner på din dator?

Jag tror att varje Windows-dator kommer med ett antivirusprogram – så ja.

Apple installerade sitt NeuralHash-program, som automatiskt skannar bildfiler för barnpornografi, på slutenheter förra året. Fungerar det på liknande sätt som ett antivirusprogram?

NeuralHash gör något liknande, även om sättet det fungerar på är annorlunda:programvaran skannar slutenheter efter en specifik typ av innehåll – inte, som med antivirusprogram, efter skadlig kod, utan efter olagliga bilder. Detta är känt som skanning på klientsidan, vilket hänvisar till genomsökning av filer på användarens enhet.

Hur exakt fungerar NeuralHash?

Programmet bygger på artificiell intelligensmetoder och använder sig av så kallade neurala nätverk. Enkelt uttryckt är det ett datorprogram som är tränat att känna igen vissa mönster i bilder. Programmet tilldelar en slags kod till varje bild, i princip en sekvens av siffror och bokstäver. Dessa koder kallas hash. Du kan föreställa dig dem som fingeravtryck som genereras för varje bild. Tricket är att bilder som ser likadana ut tilldelas samma hash – så till exempel kan alla bilder med svarta katter tilldelas hashen 3x580ac97e. Apple har en stor databas med sådana hash, som kan tilldelas barnpornografiska bilder. Och närhelst en användare försöker ladda upp en bild med en hash som finns i databasen, markeras bilden utan att användaren märker det. Sådana bilder kan inte vidarebefordras.

Betyder det att Apple vet vilka bilder som finns på min mobiltelefon?

Nej, Apple tittar inte på bilderna. Den har bara databasen med koderna. Tanken är att företaget samarbetar med barnskyddsorganisationer. Och på basis av material som kommer från brottsbekämpande myndigheter använder dessa organisationer ett program för att generera hash för databasen.

Du analyserade NeuralHash i ett forskningsprojekt med kollegor från Darmstadts tekniska universitet. Hur kom projektet till?

Neurala nätverk fungerar inte alltid som vi tror att de gör. Tekniken är mycket lovande, men den är inte alltid hundra procent korrekt. Det är ofta svårt att ta reda på varför det ger ett visst resultat, eftersom proceduren inte är explicit programmerad. I princip har denna teknik helt enkelt lärt sig att känna igen vissa mönster i datan. Detta kan dock också utnyttjas för att lura programmet — och det fungerar med alarmerande frekvens. Så vi frågade oss själva:hur påverkar detta ett system som är tänkt att användas för att bedöma olagligt innehåll? Vad händer om du till exempel ändrar bilder något?

Varför fokuserade du på NeuralHash?

2021 levererade Apple en prototyp av NeuralHash tillsammans med en operativsystemuppdatering till slutenheter – i princip alla enheter som kan skicka foton till iCloud-molnlagringstjänsten, som iPhone eller Mac. Prototypen var ännu inte aktiverad, så programmet började inte kolla bilder på Apple-enheterna. Men detta drag gjorde tekniken tillgänglig för oss; vi kunde extrahera programmet och på så sätt få tillgång till det neurala nätverket. Vi ville ta en titt på hur ett stort företag skulle gå tillväga för en sådan uppgift. Apple avstod senare från att officiellt rulla ut NeuralHash på grund av massiv kritik av den massövervakning och intrång i privatlivet det innebar.

Vad exakt testade du?

Vi testade hur systemet kunde missbrukas. För att slippa arbeta med barnpornografiskt material definierade vi bilder av hundar som "farliga". Sedan beräknade vi deras "digitala fingeravtryck". I det första scenariot tog vi bilder av andra saker, till exempel av en katt, och försökte modifiera dem något så att resultatet blev ett "fingeravtryck" av en hund.

Fungerade det?

Ja, och det visade sig vara relativt enkelt. Du behöver tillgång till det neurala nätverket – som vi hade eftersom programmet var installerat på enheterna – och du behöver lite kunskap om hur maskininlärning fungerar. Men då är det ganska enkelt att ändra kattbilderna så att de genererar annan hash. För det mänskliga ögat ser de manipulerade bilderna nästan ut som originalet, man kan inte se skillnaden riktigt.

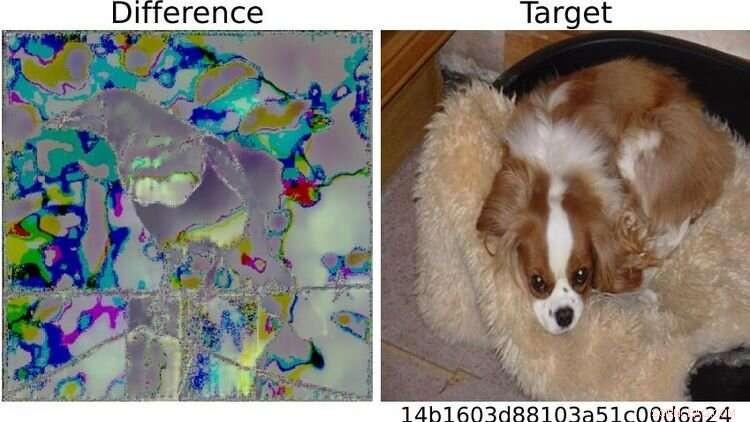

Till höger definieras hundbilden som "farlig" på testbasis. På grund av de synliga skillnaderna mellan de två skatabilderna till vänster slog systemet larm för bilden som hade ändrats på detta sätt. Den som är bekant med maskininlärning skulle alltså "relativt lätt" kunna spela ett spratt med systemet, säger Neider. Kredit:https://arxiv.org/abs/2111.06628

Och det är då saker och ting blir problematiska...

Höger. Eftersom jag skulle kunna skicka ett manipulerat foto till dig, och i samma ögonblick som du försöker ladda upp det till ditt moln eller skicka det till någon annan via en meddelandeapp, triggas systemet utan att du märker det. Du vet inte ens varför uppladdnings- eller vidarebefordringsfunktionen är blockerad. Men det verkliga problemet är att Apple också märker att du har försökt skicka en misstänkt bild. Och om detta händer för ofta dekrypterar Apple materialet och, om det anses nödvändigt, rapporterar det till de lokala brottsbekämpande myndigheterna. Det betyder att material kan planteras på någon för att anklaga dem.

Vad mer testade du?

Vi ställde också den motsatta frågan:kan jag kringgå systemet? Kan jag manipulera en bild med ett fingeravtryck i databasen på ett sådant sätt att det genererar ett annat fingeravtryck? I ett scenario antog vi återigen att användaren har tillgång till AI via sin enhet, är bekant med det neurala nätverket och har viss kunskap om maskininlärning.

Och kan bilderna manipuleras för att få dem att se otänkta ut?

Ja, det fungerar väldigt bra. Men det vi också upptäckt är att även om man inte har tillgång till systemet och gör väldigt enkla ändringar på ett foto som vem som helst kan göra med sin mobiltelefon så går det att lura programmet. Till exempel, helt enkelt genom att rotera en bild 90 grader kan du väsentligt ändra "fingeravtrycket". Detta är naturligtvis inte bra, eftersom du kan ångra denna förändring bara genom att rotera bilden 90 grader åt andra hållet. Hela informationen i bilden behålls. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. + Utforska vidare