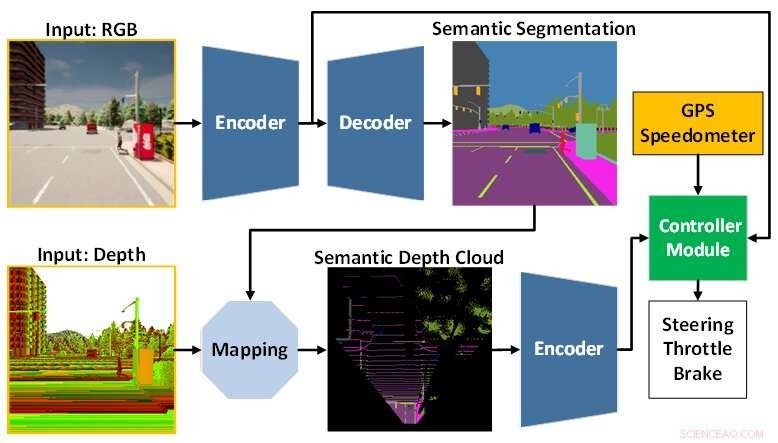

AI-modellarkitekturen består av perceptionsmodulen (blå) och styrenhetsmodulen (grön). Perceptionsmodulen ansvarar för att uppfatta miljön baserat på observationsdata från en RGBD-kamera. Samtidigt ansvarar styrmodulen för att avkoda den extraherade informationen för att uppskatta graden av styrning, gaspådrag och bromsning. Kredit:Toyohashi University of Technology

En forskargrupp bestående av Oskar Natan, fil.dr. student, och hans handledare, professor Jun Miura, som är knutna till Active Intelligent System Laboratory (AISL), Institutionen för datavetenskap, Toyohashi University of Technology, har utvecklat en AI-modell som kan hantera perception och kontroll samtidigt för en autonom körning fordon.

AI-modellen uppfattar miljön genom att utföra flera synuppgifter medan du kör fordonet efter en sekvens av ruttpunkter. Dessutom kan AI-modellen köra fordonet säkert under olika miljöförhållanden under olika scenarier. Utvärderad under punkt-till-punkt-navigeringsuppgifter, uppnår AI-modellen den bästa körbarheten av vissa nya modeller i en standardsimuleringsmiljö.

Autonom körning är ett komplext system som består av flera delsystem som hanterar flera perceptions- och kontrolluppgifter. Att distribuera flera uppgiftsspecifika moduler är dock kostsamt och ineffektivt, eftersom många konfigurationer fortfarande behövs för att bilda ett integrerat modulärt system.

Dessutom kan integrationsprocessen leda till informationsförlust då många parametrar justeras manuellt. Med snabb djupinlärningsforskning kan detta problem lösas genom att träna en enda AI-modell med end-to-end- och multi-task-manier. Således kan modellen tillhandahålla navigationskontroller enbart baserat på observationer som tillhandahålls av en uppsättning sensorer. Eftersom manuell konfiguration inte längre behövs kan modellen hantera informationen helt själv.

Utmaningen som återstår för en end-to-end-modell är hur man extraherar användbar information så att styrenheten kan uppskatta navigationskontrollerna korrekt. Detta kan lösas genom att tillhandahålla mycket data till perceptionsmodulen för att bättre uppfatta den omgivande miljön. Dessutom kan en sensorfusionsteknik användas för att förbättra prestandan eftersom den smälter samman olika sensorer för att fånga olika dataaspekter.

En enorm beräkningsbelastning är dock oundviklig eftersom en större modell behövs för att bearbeta mer data. Dessutom är en dataförbehandlingsteknik nödvändig eftersom olika sensorer ofta kommer med olika datamodaliteter. Dessutom kan obalansinlärning under träningsprocessen vara en annan fråga eftersom modellen utför både uppfattnings- och kontrolluppgifter samtidigt.

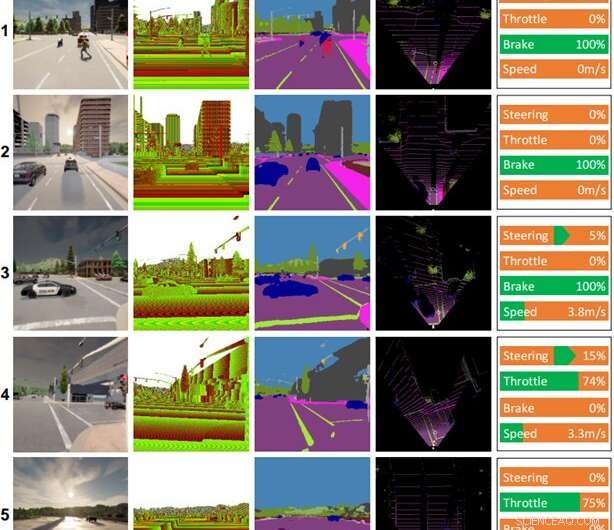

Några körrekord gjorda av AI-modellen. Kolumner (från vänster till höger):färgbild, djupbild, resultat av semantisk segmentering, karta för fågelperspektiv (BEV), kontrollkommando. Vädret och tiden för varje scen är som följer:(1) klar middag, (2) molnig solnedgång, (3) mittregnig middag, (4) hårt regnig solnedgång, (5) våt solnedgång. Kredit:Toyohashi University of Technology

För att besvara dessa utmaningar föreslår teamet en AI-modell som tränas med end-to-end- och multi-task-manier. Modellen är gjord av två huvudmoduler, nämligen perceptions- och kontrollmoduler. Perceptionsfasen börjar med att bearbeta RGB-bilder och djupkartor från en enda RGBD-kamera.

Sedan avkodas informationen som extraheras från perceptionsmodulen tillsammans med fordonshastighetsmätning och ruttpunktskoordinater av styrenhetsmodulen för att uppskatta navigationskontrollerna. För att säkerställa att alla uppgifter kan utföras lika använder teamet en algoritm som kallas modifierad gradientnormalisering (MGN) för att balansera inlärningssignalen under träningsprocessen.

Teamet överväger imitationsinlärning eftersom det tillåter modellen att lära sig från en storskalig datauppsättning för att matcha en nästan mänsklig standard. Dessutom designade teamet modellen för att använda ett mindre antal parametrar än andra för att minska beräkningsbelastningen och påskynda slutsatsen på en enhet med begränsade resurser.

Baserat på experimentresultatet i en vanlig autonom körsimulator, CARLA, avslöjas det att sammanslagning av RGB-bilder och djupkartor för att bilda en semantisk karta i fågelperspektiv (BEV) kan öka den övergripande prestandan. Eftersom perceptionsmodulen har bättre övergripande förståelse för scenen, kan styrenhetsmodulen utnyttja användbar information för att uppskatta navigationskontrollerna korrekt. Vidare uppger teamet att den föreslagna modellen är att föredra för utbyggnad eftersom den uppnår bättre körbarhet med färre parametrar än andra modeller.

Forskningen publicerades i IEEE Transactions on Intelligent Vehicles , och teamet arbetar för närvarande med modifieringar och förbättringar av modellen för att ta itu med flera problem vid körning under dåliga ljusförhållanden, som på natten, i kraftigt regn, etc. Som en hypotes tror teamet att lägga till en sensor som är opåverkad av förändringar i ljusstyrka eller belysning, såsom LiDAR, kommer att förbättra modellens scenförståelse och resultera i bättre körbarhet. En annan framtida uppgift är att tillämpa den föreslagna modellen på autonom körning i den verkliga världen. + Utforska vidare