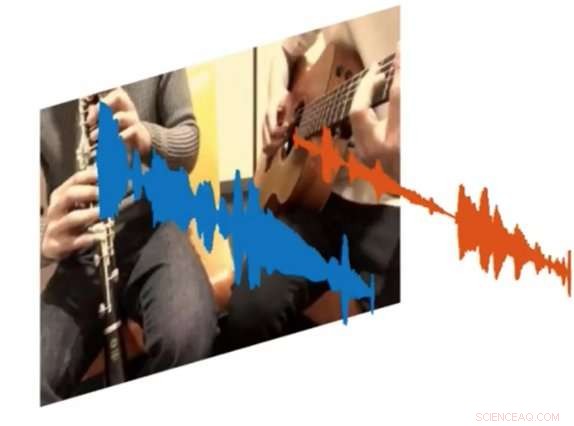

Ett nytt AI -system som heter PixelPlayer kan titta på en bild och avgöra vilken uppsättning pixlar som är ansvariga för att göra specifika uppsättningar ljudvågor. Upphovsman:MIT CSAIL

Både amatörer och professionella musiker kan spendera timmar på att hälla över YouTube -klipp för att ta reda på exakt hur man spelar vissa delar av sina favoritlåtar. Men tänk om det fanns ett sätt att spela en video och isolera det enda instrumentet du ville höra?

Det är resultatet av ett nytt AI-projekt från MIT:s datavetenskap och artificiell intelligenslaboratorium (CSAIL):ett djupinlärningssystem som kan titta på en video av en musikalisk föreställning, och isolera ljuden från specifika instrument och göra dem högre eller mjukare.

Systemet, som är "självövervakad, "kräver inga mänskliga kommentarer om vad instrumenten är eller hur de låter.

Tränade på över 60 timmars videor, "PixelPlayer" -systemet kan se en musikföreställning som aldrig har setts, identifiera specifika instrument på pixelnivå, och extrahera de ljud som är associerade med dessa instrument.

Till exempel, det kan ta en video av en tuba och en trumpet som spelar temasången "Super Mario Brothers", och separera ljudvågorna som är associerade med varje instrument.

Forskarna säger att möjligheten att ändra volymen på enskilda instrument innebär att i framtiden, system som detta kan eventuellt hjälpa ingenjörer att förbättra ljudkvaliteten för gamla konsertfilmer. Du kan till och med föreställa dig att producenter tar specifika instrumentdelar och förhandsgranskar hur de skulle låta med andra instrument (dvs en elgitarr bytte in med en akustisk).

I ett nytt papper, teamet visade att PixelPlayer kan identifiera ljuden från mer än 20 vanliga instrument. Huvudförfattaren Hang Zhao säger att systemet skulle kunna identifiera många fler instrument om det hade mer utbildningsdata, även om det fortfarande kan ha problem med att hantera subtila skillnader mellan underklasser av instrument (till exempel en altsax och en tenor).

Tidigare ansträngningar att separera ljudkällorna har uteslutande fokuserat på ljud, som ofta kräver omfattande mänsklig märkning. I kontrast, PixelPlayer introducerar synelementet, som forskarna säger gör mänskliga etiketter onödiga, eftersom vision ger självkontroll.

Systemet lokaliserar först bildregionerna som producerar ljud, och separerar sedan ingångsljuden i en uppsättning komponenter som representerar ljudet från varje pixel.

"Vi förväntade oss ett bästa fall där vi kunde känna igen vilka instrument som ger vilken typ av ljud, "säger Zhao, en doktorsexamen student på CSAIL. "Vi blev förvånade över att vi faktiskt kunde lokalisera instrumenten på pixelnivå i rymden. Att kunna göra det öppnar många möjligheter, som att kunna redigera ljudet för enskilda instrument med ett enda klick på videon. "

PixelPlayer använder metoder för "djupinlärning, "vilket betyder att den hittar mönster i data med hjälp av så kallade" neurala nätverk "som har tränats på befintliga videor. Specifikt, ett neuralt nätverk analyserar videon i videon, man analyserar ljudet, och en tredje "synthesizer" associerar specifika pixlar med specifika ljudvågor för att separera de olika ljuden.

PixelPlayer innehåller också ett gränssnitt som låter användare ändra volymen för specifika instrument i mixen. Upphovsman:MIT CSAIL

Det faktum att PixelPlayer använder så kallad "självövervakad" djupinlärning innebär att MIT-teamet inte uttryckligen förstår varje aspekt av hur det lär sig vilka instrument som gör vilka ljud.

Dock, Zhao säger att han kan berätta att systemet verkar känna igen verkliga delar av musiken. Till exempel, vissa harmoniska frekvenser tycks korrelera till instrument som fiol, medan snabba pulsliknande mönster motsvarar instrument som xylofon.

Zhao säger att ett system som PixelPlayer till och med kan användas på robotar för att bättre förstå de miljöljud som andra objekt gör, som djur eller fordon.

Denna artikel publiceras på nytt med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT -forskning, innovation och undervisning.