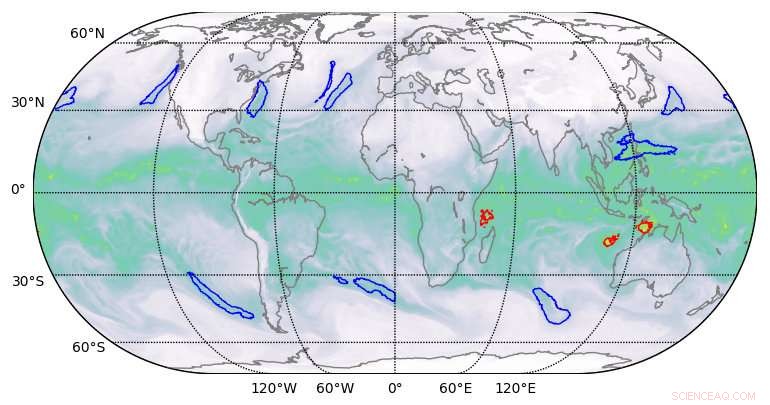

Segmenteringsresultat av hög kvalitet producerade av djupinlärning på klimatdatauppsättningar. Kredit:Berkeley Lab

Ett team av beräkningsforskare från Lawrence Berkeley National Laboratory (Berkeley Lab) och Oak Ridge National Laboratory (ORNL) och ingenjörer från NVIDIA har, för första gången, demonstrerade en applikation för djupinlärning i exascale-klass som har brutit exaop-barriären.

Med hjälp av en klimatdatauppsättning från Berkeley Lab på ORNL:s Summit-system vid Oak Ridge Leadership Computing Facility (OLCF), de tränade ett djupt neuralt nätverk för att identifiera extrema vädermönster från högupplösta klimatsimuleringar. Summit är en IBM Power Systems AC922 superdator som drivs av mer än 9, 000 IBM POWER9-processorer och 27, 000 NVIDIA Tesla V100 Tensor Core GPU:er. Genom att utnyttja de specialiserade NVIDIA Tensor Cores som är inbyggda i grafikprocessorerna i stor skala, forskarna uppnådde en toppprestanda på 1,13 exaops och en ihållande prestation på 0,999 – den snabbaste djupinlärningsalgoritmen som rapporterats hittills och en prestation som gav dem en plats på årets lista över finalister till Gordon Bell-priset.

"Detta samarbete har gett ett antal unika prestationer, sa Prabhat, som leder Data &Analytics Services-teamet vid Berkeley Labs National Energy Research Scientific Computing Center och är medförfattare på Gordon Bell-inlämningen. "Det är det första exemplet på djupinlärningsarkitektur som har kunnat lösa segmenteringsproblem inom klimatvetenskap, och inom området djupinlärning, det är det första exemplet på en verklig applikation som har brutit exaskalbarriären."

Dessa prestationer möjliggjordes genom en innovativ blandning av hårdvara och mjukvara. På hårdvarusidan, Summit har designats för att leverera 200 petaflops med högprecisionsdatorprestanda och utsågs nyligen till den snabbaste datorn i världen, kan utföra mer än tre exaops (3 miljarder miljarder beräkningar) per sekund. Systemet har en hybridarkitektur; var och en av dess 4, 608 beräkningsnoder innehåller två IBM POWER9-processorer och sex NVIDIA Volta Tensor Core GPU:er, alla anslutna via NVIDIA NVLink höghastighetsinterconnect. NVIDIA GPU:erna är en nyckelfaktor i Summits prestanda, möjliggör upp till 12 gånger högre peak teraflops för träning och 6 gånger högre peak teraflops för slutledning i djupinlärningsapplikationer jämfört med sin föregångare, Tesla P100.

"Vårt samarbete med Berkeley Lab och Oak Ridge National Laboratory visade den verkliga potentialen hos NVIDIA Tensor Core GPU:er för AI- och HPC-applikationer, sa Michael Houston, senior framstående ingenjör för djupinlärning på NVIDIA. "För att göra exaskala till verklighet, vårt team utnyttjade multiprecisionskapaciteten inpackad i de tusentals NVIDIA Volta Tensor Core GPU:erna på Summit för att uppnå toppprestanda i träning och slutsatser i applikationer för djupinlärning."

Förbättrad skalbarhet och kommunikation

På mjukvarusidan, förutom att tillhandahålla klimatdataset, Berkeley Lab-teamet utvecklade algoritmer för mönsterigenkänning för att träna det neurala nätverket DeepLabv3+ för att extrahera klassificeringar på pixelnivå av extrema vädermönster, vilket kan hjälpa till att förutsäga hur extrema väderhändelser förändras när klimatet värms upp. Enligt Thorsten Kurth, en applikationsprestandaspecialist på NERSC som ledde detta projekt, teamet gjorde ändringar i DeepLabv3+ som förbättrade nätverkets skalbarhet och kommunikationsmöjligheter och gjorde exaops-uppnåendet möjligt. Detta inkluderade att justera nätverket för att träna det att extrahera funktioner på pixelnivå och klassificering per pixel och förbättra nod-till-nod-kommunikation.

"Det som är imponerande med denna ansträngning är att vi kunde skala ett högproduktivt ramverk som TensorFlow, som är tekniskt utformad för snabb prototypframställning på små till medelstora skalor, till 4, 560 noder på Summit, " sa han. "Med ett antal prestandaförbättringar, vi kunde få ramverket att köras på nästan hela superdatorn och uppnå prestanda på exaop-nivå, vilket såvitt jag vet är det bästa som hittills uppnåtts i en tätt kopplad applikation."

Andra innovationer inkluderade höghastighets parallell datainställning, en optimerad dataintagspipeline och flerkanalssegmentering. Traditionella bildsegmenteringsuppgifter fungerar på trekanaliga röda/blåa/gröna bilder. Men vetenskapliga datamängder omfattar ofta många kanaler; i klimatet, till exempel, dessa kan inkludera temperatur, vindhastigheter, tryckvärden och luftfuktighet. Genom att köra det optimerade neurala nätverket på Summit, de ytterligare beräkningsmöjligheterna gjorde det möjligt att använda alla 16 tillgängliga kanaler, vilket dramatiskt förbättrade modellernas noggrannhet.

"Vi har visat att vi kan tillämpa djupinlärningsmetoder för segmentering på pixelnivå på klimatdata, och potentiellt på andra vetenskapliga områden, " sade Prabhat. "Mer allmänt, vårt projekt har lagt grunden för exascale djupinlärning för vetenskap, såväl som kommersiella tillämpningar."