Datavetare från Georgia Institute of Technology och Google Brain, Googles forskningsarm för artificiell intelligens, har tagit fram en ny beräkningsmetod, drivs av maskininlärningstekniker, att framgångsrikt och realistiskt simulera flerstegsprocessen med att ta på sig kläder. Upphovsman:SIGGRAPH Asia

Att ta på sig kläder är en daglig, vardaglig uppgift som de flesta av oss utför med liten eller ingen tanke. Vi kanske aldrig tar hänsyn till de flera stegen och de fysiska rörelserna när vi klär oss på morgonen. Men det är just det som behöver utforskas när man försöker fånga rörelsen med att klä sig och simulera tyg för datoranimering.

Datavetare från Georgia Institute of Technology och Google Brain, Googles forskningsarm för artificiell intelligens, har tagit fram en ny beräkningsmetod, drivs av maskininlärningstekniker, att framgångsrikt och realistiskt simulera flerstegsprocessen med att ta på sig kläder. Vid dissektion, uppgiften att klä sig är ganska komplex, och involverar flera olika fysiska interaktioner mellan karaktären och hans eller hennes kläder, främst styrs av personens beröringskänsla.

Att skapa en animering av en karaktär som tar på sig kläder är utmanande på grund av de komplexa interaktionerna mellan karaktären och det simulerade plagget. De flesta arbeten i mycket begränsad karaktärsanimering handlar om statiska miljöer som inte reagerar särskilt mycket på karaktärens rörelse, konstaterar forskarna. I kontrast, kläder kan reagera omedelbart och drastiskt på små förändringar i kroppens position; kläder har en tendens att vikas, hålla fast vid kroppen, gör haptic, eller beröringskänsla, väsentlig för uppgiften.

En annan unik utmaning när det gäller att klä sig är att det kräver att karaktären utför en lång rörelsekvens som omfattar en mängd olika deluppgifter, som att ta tag i det främre lagret på en skjorta, stoppa in en hand i skjortöppningen och tryck en hand genom en ärm.

"Att klä sig verkar lätt för många av oss eftersom vi tränar det varje dag. I verkligheten tygdynamiken gör det mycket utmanande att lära sig att klä sig från grunden, säger Alexander Clegg, huvudförfattare till forskningen och en datavetenskaplig doktorsexamen student vid Georgia Institute of Technology. "Vi utnyttjar simulering för att lära ett neuralt nätverk att utföra dessa komplexa uppgifter genom att dela upp uppgiften i mindre bitar med väldefinierade mål, låta karaktären pröva uppgiften tusentals gånger och ge belönings- eller straffsignaler när karaktären försöker fördelaktiga eller skadliga ändringar av sin policy. "

Forskarnas metod uppdaterar sedan det neurala nätverket ett steg i taget för att göra de upptäckta positiva förändringarna mer sannolika att inträffa i framtiden. "På det här sättet, vi lär karaktären hur man lyckas med uppgiften, "konstaterar Clegg.

Clegg och hans medarbetare på Georgia Tech inkluderar datavetenskapare Wenhao Yu, Greg Turk och Karen Liu. Tillsammans med Google Brain -forskare Jie Tan, gruppen kommer att presentera sitt arbete på SIGGRAPH Asia 2018 i Tokyo 4 december till 7 december. Den årliga konferensen innehåller de mest respekterade tekniska och kreativa medlemmarna inom datorgrafik och interaktiva tekniker, och visar fram spetsforskning inom vetenskap, konst, spel och animering, bland andra sektorer.

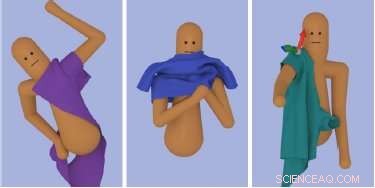

I den här studien, forskarna visade sitt tillvägagångssätt vid flera omklädningsuppgifter:att ta på sig en t-shirt, slänga på sig en jacka och robotassisterad dressing av en ärm. Med det utbildade neurala nätverket, de kunde uppnå komplex återskapande på olika sätt som en animerad karaktär tar på sig kläder. Nyckeln är att införliva känslan av beröring i deras ramar för att övervinna utmaningarna i tygsimulering. Forskarna fann att noggrant urval av tygobservationer och belöningsfunktioner i deras utbildade nätverk är avgörande för ramens framgång. Som ett resultat, detta nya tillvägagångssätt möjliggör inte bara enkla förbandssekvenser utan en karaktärskontrollant som framgångsrikt kan klä sig under olika förhållanden.

"Vi har öppnat dörren till ett nytt sätt att animera flerstegs interaktionsuppgifter i komplexa miljöer med hjälp av förstärkningslärande, "säger Clegg." Det finns fortfarande mycket arbete kvar att göra på den här vägen, tillåta simulering att ge erfarenhet och övning för uppgiftsträning i en virtuell värld. "Genom att utöka detta arbete, teamet samarbetar för närvarande med andra forskare i Georgia Techs Healthcare Robotics lab för att undersöka tillämpningen av robotik för klädhjälp.