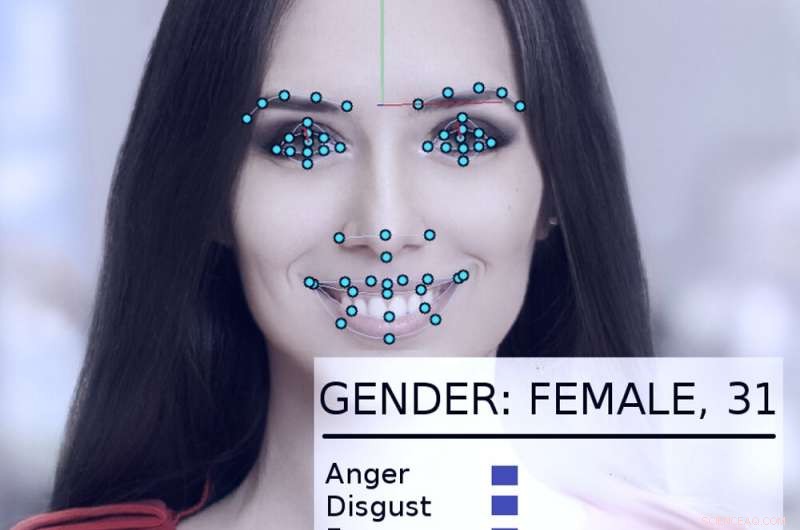

Ett system för ansiktsspårning och analys tar en titt på en kvinnas ansikte. Upphovsman:Abyssus/Wikimedia Commons, CC BY-SA

System för artificiell intelligens kan - om de används på rätt sätt - göra regeringen mer effektiv och lyhörd, förbättra medborgarnas liv. Används felaktigt, dock, de dystopiska synerna på George Orwells "1984" blir mer realistiska.

På egen hand och uppmanade av en ny presidentverkstad, regeringar i USA, inklusive statliga och federala myndigheter, undersöker sätt att använda AI -teknik.

Som AI -forskare i mer än 40 år, som varit konsult eller deltagare i många statliga projekt, Jag tror att det är värt att notera att ibland har de gjort det bra - och andra gånger inte riktigt så bra. De potentiella skadorna och fördelarna är betydande.

En tidig framgång

År 2015, USA:s Department of Homeland Security utvecklade ett AI -system som heter "Emma, "en chatbot som kan svara på frågor som ställs till den på vanlig engelska, utan att behöva veta vad "hennes" inledande webbplats kallar "regeringen talar" - alla officiella termer och förkortningar som används i byråhandlingar.

I slutet av 2016, DHS rapporterade att Emma redan hjälpte till att svara på nästan en halv miljon frågor per månad, tillåter DHS att hantera många fler förfrågningar än det hade tidigare, och låta mänskliga anställda spendera mer tid på att hjälpa människor med mer komplicerade frågor som ligger bortom Emmas förmåga. Denna typ av konversationsautomatiserande artificiell intelligens har nu använts av andra myndigheter, i städer och länder runt om i världen.

Flintens vatten

Ett mer komplicerat exempel på hur regeringar lämpligt skulle kunna tillämpa AI kan ses i Flint, Michigan. När de lokala och statliga regeringarna kämpade för att bekämpa blyföroreningar i stadens dricksvatten, blev det klart att de skulle behöva byta ut stadens kvarvarande blyvattenledningar. Dock, stadens register var ofullständiga, och det skulle bli extremt dyrt att gräva upp alla stadens rör för att se om de var bly eller koppar.

Istället, datavetare och statsanställda samarbetade för att analysera ett brett spektrum av data om var och en av 55, 000 fastigheter i staden, inklusive hur gammalt hemmet var, för att beräkna sannolikheten att det betjänades av blyrör. Innan systemet användes, 80% av de grävda rören behövde bytas ut, vilket betydde 20% av tiden, pengar och ansträngning slösades bort på rör som inte behövde bytas ut.

AI-systemet hjälpte ingenjörer att fokusera på högriskegenskaper, identifiera en uppsättning egenskaper som sannolikt kommer att behöva byta rör. När stadsinspektörer besökte för att verifiera situationen, algoritmen hade rätt 70% av tiden. Det lovade att spara enorma mängder pengar och påskynda rörbytesprocessen.

Dock, lokalpolitik kom i vägen. Många av allmänheten förstod inte varför systemet identifierade de hem det gjorde, och invände, säger att AI -metoden orättvist ignorerade deras hem. Efter att stadens tjänstemän slutade använda algoritmen, endast 15% av de grävda rören var bly. Det gjorde utbytesprojektet långsammare och dyrare.

Bedrövande exempel

Problemet i Flint var att människor inte förstod att AI -teknik användes väl, och att människor verifierade sina fynd med oberoende inspektioner. Till viss del, detta var för att de inte litade på AI - och i vissa fall finns det god anledning till det.

År 2017, Jag var med i en grupp på mer än fyra dussin AI -forskare som skickade ett brev till den tillförordnade sekreteraren vid U.S. Department of Homeland Security. Vi uttryckte oro över ett förslag om att använda automatiserade system för att avgöra om en person som söker asyl i USA skulle bli en "positivt bidragande medlem i samhället" eller mer sannolikt skulle vara ett terrorhot.

"Enkelt uttryckt, "i vårt brev stod det "inga beräkningsmetoder kan ge tillförlitliga eller objektiva bedömningar av de egenskaper som [DHS] försöker mäta." Vi förklarade att maskininlärning är mottagligt för ett problem som kallas "dataskrävning, "där systemets förmåga att förutsäga en egenskap delvis beror på hur vanlig den egenskapen är i data som används för att träna systemet.

Så i en databas med 300 miljoner amerikaner, om en av 100 personer är, säga, av indisk härkomst, systemet kommer att vara ganska exakt vid identifiering av dem. Men om man tittar på en egenskap som delas av bara en av en miljon amerikaner, det finns verkligen inte tillräckligt med data för att algoritmen ska kunna göra en bra analys.

Som brevet förklarade, "på den amerikanska befolkningens skala och invandringstakten, brottsliga handlingar är relativt sällsynta, och terrorhandlingar är extremt sällsynta. "Algoritmisk analys är ytterst osannolikt för att identifiera potentiella terrorister. Lyckligtvis, våra argument visade sig övertygande. I maj 2018, DHS meddelade att det inte skulle använda en maskininlärningsalgoritm på detta sätt.

Andra oroande insatser

Andra regeringsanvändningar av AI ifrågasätts, också - till exempel försök till "förutsägande polisarbete, "fastställande av borgenbelopp och straffrättsliga straff och anställning av statliga arbetare. Alla dessa har visat sig vara mottagliga för tekniska problem och datagränser som kan förspänna deras beslut baserat på ras, kön eller kulturell bakgrund.

Andra AI -tekniker som ansiktsigenkänning, automatisk övervakning och massdatainsamling väcker verkliga bekymmer om säkerheten, Integritet, rättvisa och noggrannhet i ett demokratiskt samhälle.

Som Trumps verkställande order visar, det finns ett stort intresse för att utnyttja AI för sin fulla positiva potential. Men de betydande farorna med övergrepp, missbruk och partiskhet - oavsett om det är avsiktligt eller inte - har potential att arbeta mot de principer som internationella demokratier har byggt på.

När användningen av AI -teknik ökar, om det ursprungligen är välmenat eller medvetet auktoritärt, risken för övergrepp ökar också. Utan att det för närvarande finns någon övergripande tillsyn på plats i USA, det bästa sättet att undvika dessa övergrepp är att lära allmänheten om lämplig användning av AI genom samtal mellan forskare, oroade medborgare och offentliga administratörer för att avgöra när och var det är olämpligt att använda dessa kraftfulla nya verktyg.

Denna artikel publiceras från The Conversation under en Creative Commons -licens. Läs originalartikeln.