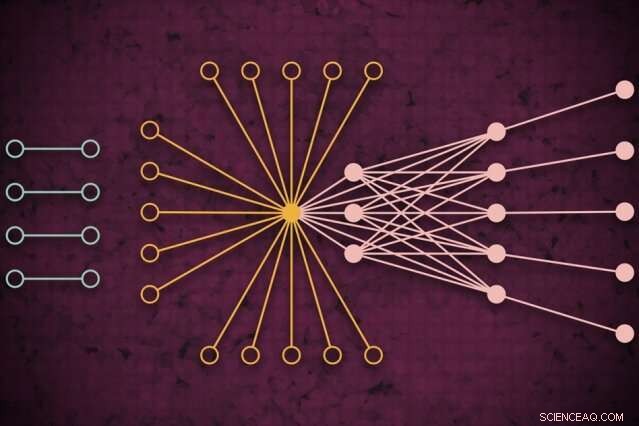

Med hjälp av ett superdatorsystem, MIT-forskare utvecklade en modell som fångar hur global webbtrafik kan se ut en viss dag, inklusive tidigare osynliga isolerade länkar (vänster) som sällan ansluter men verkar påverka kärntrafiken på webben (höger). Kredit:MIT News

Med hjälp av ett superdator system, MIT-forskare har utvecklat en modell som fångar hur webbtrafik ser ut runt om i världen en viss dag, som kan användas som ett mätverktyg för internetforskning och många andra applikationer.

Förstå webbtrafikmönster i så stor skala, forskarna säger, är användbar för att informera om internetpolicy, identifiera och förebygga avbrott, försvara sig mot cyberattacker, och designa mer effektiv datorinfrastruktur. Ett dokument som beskriver tillvägagångssättet presenterades vid IEEE High Performance Extreme Computing Conference nyligen.

För deras arbete, forskarna samlade den största allmänt tillgängliga internettrafikdataset, omfattande 50 miljarder datapaket utbytta på olika platser över hela världen under en period av flera år.

De körde data genom en ny "neuralt nätverk" pipeline som fungerar över 10, 000 processorer av MIT SuperCloud, ett system som kombinerar datorresurser från MIT Lincoln Laboratory och över institutet. Den pipelinen tränade automatiskt en modell som fångar relationen för alla länkar i datamängden – från vanliga pingar till jättar som Google och Facebook, till sällsynta länkar som bara ansluter kort men ändå verkar ha en viss inverkan på webbtrafiken.

Modellen kan ta vilken massiv nätverksuppsättning som helst och generera några statistiska mätningar om hur alla anslutningar i nätverket påverkar varandra. Det kan användas för att avslöja insikter om peer-to-peer-fildelning, otrevliga IP-adresser och skräppostbeteende, fördelningen av attacker i kritiska sektorer, och trafikera flaskhalsar för att bättre allokera datorresurser och hålla dataflödet.

I konceptet, verket liknar att mäta den kosmiska mikrovågsbakgrunden i rymden, de nästan enhetliga radiovågorna som färdas runt i vårt universum som har varit en viktig informationskälla för att studera fenomen i yttre rymden. "Vi byggde en noggrann modell för att mäta bakgrunden av Internets virtuella universum, säger Jeremy Kepner, en forskare vid MIT Lincoln Laboratory Supercomputing Center och en utbildad astronom. "Om du vill upptäcka någon avvikelse eller anomalier, du måste ha en bra modell av bakgrunden."

Med Kepner på tidningen är:Kenjiro Cho från Internet Initiative Japan; KC Claffy från Center for Applied Internet Data Analysis vid University of California i San Diego; Vijay Gadepally och Peter Michaleas från Lincoln Laboratorys Supercomputing Center; och Lauren Milechin, en forskare vid MIT:s Department of Earth, Atmosfärs- och planetvetenskap.

Bryter upp data

I internetforskning, experter studerar avvikelser i webbtrafik som kan indikera, till exempel, cyberhot. Att göra så, det hjälper att först förstå hur normal trafik ser ut. Men att fånga det har förblivit utmanande. Traditionella "trafikanalys"-modeller kan endast analysera små urval av datapaket som utbyts mellan källor och destinationer som är begränsade av plats. Det minskar modellens noggrannhet.

Forskarna var inte specifikt ute efter att ta itu med denna trafikanalysfråga. Men de hade utvecklat nya tekniker som kunde användas på MIT SuperCloud för att bearbeta massiva nätverksmatriser. Internettrafik var det perfekta testfallet.

Nätverk studeras vanligtvis i form av grafer, med skådespelare representerade av noder, och länkar som representerar förbindelser mellan noderna. Med internettrafik, noderna varierar i storlek och placering. Stora supernoder är populära nav, som Google eller Facebook. Bladnoder sprids ut från den supernoden och har flera anslutningar till varandra och supernoden. Utanför denna "kärna" av supernoder och bladnoder finns isolerade noder och länkar, som bara sällan ansluter till varandra.

Att fånga hela omfattningen av dessa grafer är omöjligt för traditionella modeller. "Du kan inte röra den informationen utan åtkomst till en superdator, " säger Kepner.

I samarbete med projektet Widely Integrated Distributed Environment (WIDE), grundades av flera japanska universitet, och Center for Applied Internet Data Analysis (CAIDA), i Kalifornien, MIT-forskarna fångade världens största paketinsamlingsdataset för internettrafik. Den anonymiserade datamängden innehåller nästan 50 miljarder unika käll- och destinationsdatapunkter mellan konsumenter och olika appar och tjänster under slumpmässiga dagar på olika platser över Japan och USA, går tillbaka till 2015.

Innan de kunde träna någon modell på dessa data, de behövde göra en omfattande förbearbetning. Att göra så, de använde programvara de skapat tidigare, kallas Dynamic Distributed Dimensional Data Mode (D4M), som använder vissa medelvärdestekniker för att effektivt beräkna och sortera "hyperglesa data" som innehåller mycket mer tomt utrymme än datapunkter. Forskarna delade upp data i enheter på cirka 100, 000 paket över 10, 000 MIT SuperCloud-processorer. Detta genererade mer kompakta matriser på miljarder rader och kolumner med interaktioner mellan källor och destinationer.

Fånga extremvärden

Men den stora majoriteten av cellerna i denna hyperglesa dataset var fortfarande tomma. För att bearbeta matriserna, laget drev ett neuralt nätverk på samma 10, 000 kärnor. Bakom kulisserna, en trial-and-error-teknik började anpassa modeller till hela data, skapa en sannolikhetsfördelning av potentiellt korrekta modeller.

Sedan, den använde en modifierad felkorrigeringsteknik för att ytterligare förfina parametrarna för varje modell för att fånga så mycket data som möjligt. Traditionellt, felkorrigerande tekniker i maskininlärning kommer att försöka minska betydelsen av eventuella externa data för att få modellen att passa en normal sannolikhetsfördelning, vilket gör det mer exakt överlag. Men forskarna använde några matematiska knep för att säkerställa att modellen fortfarande såg all yttre data - som isolerade länkar - som betydelsefulla för de övergripande mätningarna.

I slutet, det neurala nätverket genererar i huvudsak en enkel modell, med bara två parametrar, som beskriver internettrafikdataset, "från riktigt populära noder till isolerade noder, och hela spektrat av allt däremellan, "Säger Kepner.

Forskarna når nu ut till forskarvärlden för att hitta sin nästa applikation för modellen. Experter, till exempel, kunde undersöka betydelsen av de isolerade länkar som forskarna hittade i sina experiment som är sällsynta men som verkar påverka webbtrafiken i kärnnoderna.

Bortom internet, den neurala nätverksrörledningen kan användas för att analysera alla hypersparna nätverk, såsom biologiska och sociala nätverk. "Vi har nu gett forskarsamhället ett fantastiskt verktyg för människor som vill bygga mer robusta nätverk eller upptäcka anomalier i nätverk, " säger Kepner. "Dessa anomalier kan bara vara normala beteenden för vad användare gör, eller så kan det vara människor som gör saker du inte vill."

Den här historien återpubliceras med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT-forskning, innovation och undervisning.