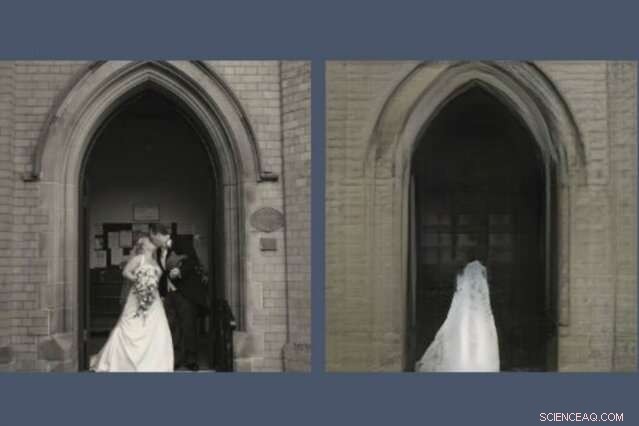

Ett nytt verktyg avslöjar vad AI -modeller utelämnar vid återskapande av en scen. Här, ett GAN, eller generativt kontradiktoriskt nätverk, har tappat paret nygifta från sin rekonstruktion (höger) av fotot som det blev ombedd att rita (vänster). Upphovsman:Massachusetts Institute of Technology

Alla som har spenderat tid på sociala medier har förmodligen märkt att GAN, eller generativa motsatta nätverk, har blivit anmärkningsvärt bra på att rita ansikten. De kan förutsäga hur du kommer att se ut när du är gammal och hur du skulle se ut som en kändis. Men be ett GAN att rita scener från den större världen och saker blir konstiga.

En ny demo av MIT-IBM Watson AI Lab avslöjar vad en modell som tränats på scener av kyrkor och monument bestämmer sig för att utelämna när den ritar sin egen version av, säga, Pantheon i Paris, eller Piazza di Spagna i Rom. Den större studien, Se vad ett GAN inte kan generera, presenterades vid den internationella konferensen om datorsyn förra veckan.

"Forskare fokuserar vanligtvis på att karakterisera och förbättra vad ett maskininlärningssystem kan göra-vad det uppmärksammar, och hur specifika ingångar leder till särskilda utgångar, "säger David Bau, en doktorand vid MIT:s avdelning för elektroteknik och datavetenskap och datavetenskap och artificiellt vetenskapslaboratorium (CSAIL). "Med detta arbete, Vi hoppas att forskare kommer att ägna lika mycket uppmärksamhet åt att karakterisera data som dessa system ignorerar. "

I ett GAN, ett par neurala nätverk arbetar tillsammans för att skapa hyperrealistiska bilder mönstrade efter exempel de har fått. Bau blev intresserad av GAN som ett sätt att kika in i svartlådiga neurala nät för att förstå resonemanget bakom deras beslut. Ett tidigare verktyg utvecklat med sin rådgivare, MIT -professor Antonio Torralba, och IBM -forskaren Hendrik Strobelt, gjort det möjligt att identifiera klustren av artificiella neuroner som är ansvariga för att organisera bilden i verkliga kategorier som dörrar, träd, och moln. Ett relaterat verktyg, GANPaint, låter amatörartister lägga till och ta bort dessa funktioner från egna foton.

En dag, samtidigt som han hjälper en konstnär att använda GANPaint, Bau stötte på ett problem. "Som vanligt, vi jagade siffrorna, försöker optimera numerisk förlust av rekonstruktion för att rekonstruera fotot, "säger han." Men min rådgivare har alltid uppmuntrat oss att se bortom siffrorna och granska de faktiska bilderna. När vi tittade, fenomenet hoppade rakt ut:Folk tappades selektivt. "

Precis som GAN och andra neurala nät hittar mönster i massor av data, de ignorerar mönster, för. Bau och hans kollegor utbildade olika typer av GAN:er inomhus och utomhus. Men oavsett var bilderna togs, GAN utelämnade konsekvent viktiga detaljer som människor, bilar, tecken, fontäner, och möbler, även när dessa föremål framträdde framträdande i bilden. I en GAN -rekonstruktion, ett par nygifta kyssar på trappan i en kyrka spöks ut, lämnar en kuslig bröllopsklänning textur på katedralen dörren.

"När GAN:er stöter på objekt som de inte kan generera, de verkar föreställa sig hur scenen skulle se ut utan dem, "säger Strobelt." Ibland blir människor buskar eller försvinner helt in i byggnaden bakom dem. "

Forskarna misstänker att maskinlyssning kan vara skyldig; även om ett GAN är utbildat för att skapa övertygande bilder, det kan lära sig att det är lättare att fokusera på byggnader och landskap och hoppa över svårare att representera människor och bilar. Forskare har länge vetat att GAN har en tendens att förbise några statistiskt meningsfulla detaljer. Men detta kan vara den första studien som visar att toppmoderna GAN:er systematiskt kan utelämna hela klasser av objekt i en bild.

En AI som släpper några objekt från sina representationer kan uppnå sina numeriska mål samtidigt som de saknar de viktigaste detaljerna för oss människor, säger Bau. När ingenjörer vänder sig till GAN för att generera syntetiska bilder för att träna automatiserade system som självkörande bilar, det finns en fara för att människor, tecken, och annan kritisk information kan släppas utan att människor inser. Det visar varför modellprestanda inte ska mätas med enbart noggrannhet, säger Bau. "Vi måste förstå vad nätverken är och inte gör för att se till att de gör de val vi vill att de ska göra."

Denna artikel publiceras på nytt med tillstånd av MIT News (web.mit.edu/newsoffice/), en populär webbplats som täcker nyheter om MIT -forskning, innovation och undervisning.