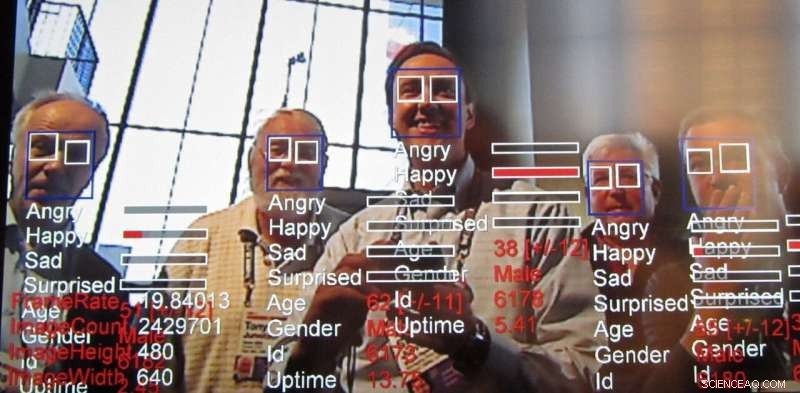

Känsloigenkänningsteknik, en utväxt av ansiktsigenkänningsteknik, fortsätter att avancera snabbt. Kredit:Steve Jurvetson/flickr, CC BY-SA

I sin årsredovisning, AI Now Institute, ett tvärvetenskapligt forskningscenter som studerar de samhälleliga konsekvenserna av artificiell intelligens, efterlyste ett förbud mot teknik utformad för att känna igen människors känslor i vissa fall. Specifikt, forskarna sa att teknik för att påverka igenkänning, även kallad emotion recognition technology, bör inte användas i beslut som "påverkar människors liv och tillgång till möjligheter, "såsom anställningsbeslut eller smärtbedömningar, eftersom det inte är tillräckligt korrekt och kan leda till partiska beslut.

Vad är denna teknik, som redan används och marknadsförs, och varför väcker det oro?

Utväxt av ansiktsigenkänning

Forskare har aktivt arbetat med datorseendealgoritmer som kan bestämma känslor och avsikter hos människor, tillsammans med att dra andra slutsatser, i minst ett decennium. Analys av ansiktsuttryck har funnits sedan åtminstone 2003. Datorer har kunnat förstå känslor ännu längre. Den senaste tekniken bygger på datacentrerade tekniker som kallas "maskininlärning, "algoritmer som bearbetar data för att "lära sig" hur man fattar beslut, för att åstadkomma ännu mer exakt affektigenkänning.

Utmaningen att läsa känslor

Forskare letar alltid efter att göra nya saker genom att bygga vidare på det som har gjorts tidigare. Känsloigenkänning är lockande eftersom, på något sätt, vi som människor kan åstadkomma detta relativt bra redan från en tidig ålder, och ändå att kunna replikera den mänskliga skickligheten med datorseende är fortfarande utmanande. Även om det är möjligt att göra några ganska anmärkningsvärda saker med bilder, stilisera ett foto för att få det att se ut som om det var ritat av en känd konstnär och till och med skapa fotorealistiska ansikten – för att inte tala om skapa så kallade deepfakes – förmågan att härleda egenskaper som mänskliga känslor från en verklig bild har alltid varit av intresse för forskare.

Känslor är svåra eftersom de tenderar att bero på sammanhang. Till exempel, när någon koncentrerar sig på något kan det verka som att de helt enkelt tänker. Ansiktsigenkänning har kommit långt med hjälp av maskininlärning, men att identifiera en persons känslomässiga tillstånd baserat enbart på att titta på en persons ansikte saknar nyckelinformation. Känslor uttrycks inte bara genom en persons uttryck utan också var de är och vad de gör. Dessa kontextuella ledtrådar är svåra att mata in i även moderna maskininlärningsalgoritmer. För att ta itu med detta, det finns aktiva ansträngningar för att utöka artificiell intelligenstekniker för att överväga sammanhang, inte bara för att känna igen känslor utan alla typer av applikationer.

Läser anställdas känslor

Rapporten som släppts av AI Now belyser några sätt på vilka AI tillämpas på arbetskraften för att utvärdera arbetarnas produktivitet och till och med så tidigt som i intervjustadiet. Analyserar bilder från intervjuer, speciellt för arbetssökande på distans, är redan igång. Om chefer kan få en känsla av sina underordnades känslor från intervju till utvärdering, beslutsfattande i andra anställningsfrågor såsom löneförhöjningar, kampanjer eller uppdrag kan komma att påverkas av den informationen. Men det finns många andra sätt att använda denna teknik.

Varför oroa sig

Dessa typer av system har nästan alltid rättvisa, ansvarighet, transparens och etiska ("ÖDE") brister inbakade i deras mönstermatchning. Till exempel, en studie fann att ansiktsigenkänningsalgoritmer bedömde ansikten på svarta människor som argare än vita ansikten, även när de log.

Många forskargrupper tar itu med detta problem, men det verkar uppenbart vid denna tidpunkt att problemet inte kan lösas uteslutande på teknisk nivå. Frågor om FATE i AI kommer att kräva en fortsatt och samlad ansträngning från dem som använder tekniken för att vara medvetna om dessa problem och att ta itu med dem. Som AI Now-rapporten framhåller:"Trots ökningen av AI-etikinnehåll ... fokuserar etiska principer och uttalanden sällan på hur AI-etik kan implementeras och om de är effektiva." Den noterar att sådana AI-etiska uttalanden till stor del ignorerar frågor om hur, var, och vem som kommer att tillämpa sådana riktlinjer. I verkligheten, det är troligt att alla måste vara medvetna om vilka typer av fördomar och svagheter som dessa system uppvisar, liknande hur vi måste vara medvetna om våra egna fördomar och andras.

Problemet med generella teknikförbud

Större noggrannhet och enkelhet i ihållande övervakning för med sig andra problem utöver etik. Det finns också en mängd allmänna teknikrelaterade integritetsproblem, allt från spridningen av kameror som fungerar som polisflöden till att potentiellt göra känsliga uppgifter anonyma.

Med dessa etiska och integritetsfrågor, en naturlig reaktion kan vara att kräva ett förbud mot dessa tekniker. Säkert, Att tillämpa AI på resultat av anställningsintervjuer eller straffrättsliga förfaranden verkar farligt om systemen är inlärningsfördomar eller på annat sätt är opålitliga. Det finns dock användbara applikationer, till exempel för att hjälpa till att upptäcka varningsskyltar för att förhindra ungdomssjälvmord och upptäcka rattfulla förare. Det är en anledning till att till och med oroade forskare, Tillsynsmyndigheter och medborgare har i allmänhet slutat med att kräva generella förbud mot AI-relaterad teknik.

Kombinera AI och mänskligt omdöme

I sista hand, teknikdesigners och samhället som helhet måste titta noga på hur information från AI-system injiceras i beslutsprocesser. Dessa system kan ge felaktiga resultat precis som alla andra former av intelligens. De är också notoriskt dåliga på att betygsätta sitt eget förtroende, inte olikt människor, även i enklare uppgifter som förmågan att känna igen objekt. Det återstår också betydande tekniska utmaningar när det gäller att läsa känslor, särskilt med tanke på sammanhang för att sluta sig till känslor.

Om människor litar på ett system som inte är korrekt när de fattar beslut, användarna av det systemet har det sämre. Det är också välkänt att människor tenderar att lita på dessa system mer än andra auktoritetspersoner. I ljuset av detta, vi som samhälle måste noga överväga dessa systems rättvisa, ansvarighet, transparens och etik både under design och tillämpning, alltid ha en människa som den slutliga beslutsfattaren.

Den här artikeln är återpublicerad från The Conversation under en Creative Commons-licens. Läs originalartikeln.