När en katastrof inträffar krävs ett snabbt och samordnat ingripande, och det kräver data för att bedöma skadans art, omfattningen av insatsen som behövs och för att planera säkra evakueringar.

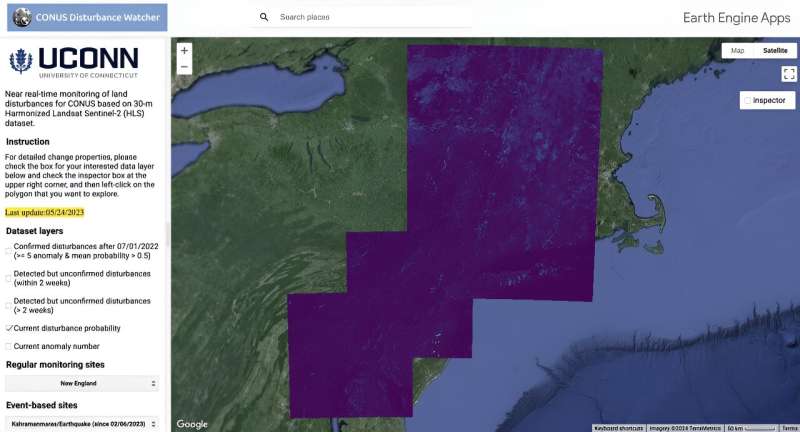

Från marken kan denna datainsamling ta dagar eller veckor, men ett team av UConn-forskare har hittat ett sätt att drastiskt minska eftersläpningstiden för dessa bedömningar med hjälp av fjärranalysdata och maskininlärning, för att föra störningsbedömning närmare nära realtid ( NRT) övervakning. Deras resultat publiceras i Remote Sensing of Environment .

Su Ye, en postdoktorand forskare vid UConns Global Environmental Remote Sensing Laboratory (GERS) och tidningens första författare, säger att han inspirerades av metoder som används av biomedicinska forskare för att studera de tidigaste symtomen på infektioner.

"Det är en väldigt intuitiv idé", säger Ye. "Till exempel, med covid kan de tidiga symptomen vara mycket subtila, och du kan inte säga att det är covid förrän flera veckor senare när symptomen blir allvarliga och sedan bekräftar infektion."

Ye förklarar att den här metoden kallas retrospektiv diagramgranskning (RCR) och den är särskilt användbar för att lära dig mer om infektioner som har en lång latensperiod mellan den första exponeringen för utvecklingen av uppenbar infektion.

"Denna forskning använder samma idéer. När vi gör markstörningsövervakning av saker som katastrofer eller sjukdomar i skogar, till exempel i början av våra fjärranalysobservationer, kan vi ha väldigt få eller bara en fjärranalysbild, så att fånga symptomen tidigt kan vara mycket fördelaktigt", säger Ye.

Flera dagar eller veckor efter en störning kan forskare bekräfta en förändring, och precis som en patient som diagnostiserats med covid, resonerade Ye att de kunde spåra tillbaka och göra en retrospektiv analys för att se om tidigare signaler kunde hittas i data och om dessa data kunde användas för att konstruera en modell för nästan realtidsövervakning.

Ye förklarar att de har en mängd data att arbeta med – till exempel Landsat-data sträcker sig 50 år tillbaka i tiden – så teamet skulle kunna utföra en fullständig retrospektiv analys för att hjälpa till att skapa en algoritm som kan upptäcka förändringar mycket snabbare än nuvarande metoder som förlitar sig på en mer manuellt tillvägagångssätt.

"Det finns så mycket data och många bra produkter men vi har aldrig utnyttjat dem till fullo för att retrospektivt analysera symptomen för framtida analys. Vi har aldrig kopplat ihop det förflutna och framtiden, men detta arbete för samman dessa två."

Docent vid institutionen för naturresurser och miljö och chef för GERS-laboratoriet Zhe Zhu säger att de använde de mängder av tillgängliga data och tillämpad maskininlärning, tillsammans med fysiska hinder för att banbryta en teknik som tänjer på gränsen för nästan realtidsdetektering till högst fyra dagar i motsats till en månad eller mer.

Fram till nu var tidig upptäckt mer utmanande, eftersom det är svårare att skilja förändringar i de tidiga stadierna efter störningar, säger Zhu.

"Dessa data innehåller mycket brus som orsakas av saker som moln, molnskuggor, rök, aerosoler, till och med årstidernas växlingar, och att ta hänsyn till dessa variationer gör tolkningen av verkliga förändringar på jordens yta svår, särskilt när målet är att upptäcka dessa störningar så snart som möjligt."

En nyckelpunkt i utvecklingen av metoden är öppen tillgång till de mest avancerade data som finns tillgängliga med medelupplösning, säger Ye.

"Forskare i USA samarbetar med europeiska forskare, och vi kombinerar alla fyra satelliterna, så vi har byggt på många, många andras arbete. Satellitteknologier som Landsat – jag tror att det är ett av de största projekten i mänsklighetens historia. "

Utöver att göra bilderna öppen källkod, tillägger Zhu att datamängden – NASA Harmonized Landsat och Sentinel-2 data (HLS) – harmoniserades av ett team på NASA, vilket innebär att Landsat- och Sentinel-2-data var alla kalibrerade till samma upplösning, vilket sparar mycket bearbetningstid och gör att forskare kan börja arbeta med datan direkt,

"Utan NASA HLS-data kan vi spendera månader på att bara få informationen klar."

Ye förklarar att de sätter trösklar baserat på empirisk kunskap från vad som setts i tidigare markstörningar. De tittar på signaler i datan, så kallade spektrala förändringar, och beräknar förändringens totala storlek för att hjälpa till att skilja bruset från de tidiga signalerna om störningar.

Detta tillvägagångssätt ignorerar annan relevant viktig störningsrelaterad information såsom spektral förändringsvinkel, säsongsmönster, markförhållanden före störning, säger Ye.

"Den nya metoden låter tidigare data övervaka oss för att hitta de verkliga signalerna. Till exempel förekommer vissa störningar under vissa årstider, så likheter kan tas med i beräkningen, och vissa störningar har speciella spektrala egenskaper som kommer att öka vid vissa band, men minska i andra band kan vi sedan använda data för att bygga en modell för att bättre karakterisera förändringarna."

Å andra sidan utnyttjade vi många befintliga störningsprodukter som kunde användas som träningsdata i maskininlärning och AI, säger Zhu.

"När den här enorma mängden träningsdata väl har samlats in kan det finnas några felaktiga pixlar, men detta tillvägagångssätt för maskininlärning kan förfina resultaten ytterligare och ge bättre resultat. Det är som om de fysiska, statistiska reglerna talar till metoden för maskininlärning och de arbeta tillsammans för att förbättra resultaten."

Medförfattare och postdoktor Ji Won Suh säger att teamet är angelägna om att fortsätta arbeta med denna metod och att övervaka landstörningar i hela landet.

"För framtida riktningar hoppas jag att vi kan hjälpa till att berätta historien om socioekonomiska effekter och vad som händer i vårt jordsystem. Om tätare tidsseriedata finns tillgängliga och mer datalagring är tillgänglig, tillsammans med denna algoritm, kan vi kan förstå vårt system mer intuitivt. Jag ser mycket fram emot framtiden."

Zhu säger att tillvägagångssättet redan väcker intresse, och han förväntar sig att intresset kommer att växa. Deras arbete är öppen källkod och Zhu säger att de gärna hjälper andra grupper att anta metoden. Plattformen har redan använts för katastrofövervakning nästan i realtid. I efterdyningarna av orkanen Ian använde teamet snabbt denna metod för att hjälpa till med återhämtningsansträngningarna.

"Jag tror att det är extremt fördelaktigt", säger Zhu. "Om någon form av katastrof inträffar kan vi snabbt se skadorna i området och fastställa omfattningen och den uppskattade kostnaden för återhämtning. Vi hoppas kunna ha detta omfattande övervakningssystem för markstörningar i nästan realtid för att hjälpa människor att minska skada från de stora katastroferna."

Mer information: Su Ye et al, Utnyttja tidigare information och maskininlärning för att påskynda övervakning av landstörningar, Remote Sensing of Environment (2024). DOI:10.1016/j.rse.2024.114071

Tillhandahålls av University of Connecticut