Kredit:Konversationen

En intern Facebook-rapport fann att den sociala medieplattformens algoritmer – reglerna som dess datorer följer för att bestämma innehållet du ser – gjorde det möjligt för desinformationskampanjer baserade i Östeuropa att nå nästan hälften av alla amerikaner inför presidentvalet 2020, enligt en rapport i Technology Review.

Kampanjerna producerade de mest populära sidorna för kristet och svart amerikanskt innehåll, och nådde totalt 140 miljoner amerikanska användare per månad. Sjuttiofem procent av personerna som exponerats för innehållet hade inte följt någon av sidorna. Folk såg innehållet eftersom Facebooks innehållsrekommendationssystem lade det i sina nyhetsflöden.

Sociala medieplattformar är mycket beroende av människors beteende för att bestämma innehållet du ser. Särskilt, de tittar efter innehåll som folk svarar på eller "engagerar sig" med genom att gilla, kommentera och dela. Troll gårdar, organisationer som sprider provocerande innehåll, utnyttja detta genom att kopiera innehåll med högt engagemang och lägga upp det som sitt eget.

Som datavetare som studerar hur många människor interagerar med hjälp av teknik, Jag förstår logiken i att använda folkmassornas visdom i dessa algoritmer. Jag ser också stora fallgropar i hur sociala medieföretagen gör det i praktiken.

På tröskeln till valet 2020, trollfarmar drev stora sidnätverk på FB inriktade på Christian, Svart, &Indianer. En intern rapport som spårade situationen beskrev den som "verkligt skrämmande". Några av sidorna finns kvar två år senare. https://t.co/Wa43f8rG0N

— Karen Hao (@_KarenHao) 17 september, 2021

Från lejon på savannen till likes på Facebook

Konceptet med folkmassornas visdom antar att man använder signaler från andras handlingar, åsikter och preferenser som vägledning kommer att leda till sunda beslut. Till exempel, kollektiva förutsägelser är normalt mer exakta än enskilda. Kollektiv intelligens används för att förutsäga finansiella marknader, sporter, val och till och med sjukdomsutbrott.

Under miljontals år av evolution, dessa principer har kodats in i den mänskliga hjärnan i form av kognitiva fördomar som kommer med namn som förtrogenhet, blott exponering och bandwagon-effekt. Om alla börjar springa, du bör också börja springa; kanske någon såg ett lejon komma och springa kan rädda ditt liv. Du kanske inte vet varför, men det är klokare att ställa frågor senare.

Din hjärna tar upp ledtrådar från omgivningen – inklusive dina kamrater – och använder enkla regler för att snabbt översätta dessa signaler till beslut:Gå med vinnaren, följa majoriteten, kopiera din granne. Dessa regler fungerar anmärkningsvärt bra i typiska situationer eftersom de är baserade på sunda antaganden. Till exempel, de antar att människor ofta handlar rationellt, det är osannolikt att många har fel, det förflutna förutspår framtiden, och så vidare.

Tekniken gör det möjligt för människor att komma åt signaler från ett mycket större antal andra människor, av vilka de flesta inte känner. Artificiell intelligens applikationer använder kraftigt dessa popularitets- eller "engagemangssignaler", från att välja sökmotorresultat till att rekommendera musik och videor, och från att föreslå vänner till att rangordna inlägg i nyhetsflöden.

Allt viralt förtjänar inte att vara

Vår forskning visar att praktiskt taget alla webbteknikplattformar, såsom sociala medier och nyhetsrekommendationssystem, har en stark popularitetsbias. När applikationer drivs av ledtrådar som engagemang snarare än explicita sökmotorfrågor, popularitetsbias kan leda till skadliga oavsiktliga konsekvenser.

Sociala medier som Facebook, Instagram, Twitter, YouTube och TikTok förlitar sig starkt på AI-algoritmer för att rangordna och rekommendera innehåll. Dessa algoritmer tar som input vad du gillar, kommentera och dela – med andra ord, innehåll du engagerar dig i. Målet med algoritmerna är att maximera engagemanget genom att ta reda på vad folk gillar och ranka det högst upp i sina flöden.

På ytan verkar detta rimligt. Om folk gillar trovärdiga nyheter, expertutlåtanden och roliga videor, dessa algoritmer bör identifiera sådant högkvalitativt innehåll. Men folkmassornas visdom gör här ett viktigt antagande:att rekommendera vad som är populärt kommer att hjälpa högkvalitativt innehåll att "bubbla upp".

Vi testade detta antagande genom att studera en algoritm som rangordnar objekt med en blandning av kvalitet och popularitet. Vi fann att i allmänhet, popularitetsbias är mer sannolikt att sänka den övergripande kvaliteten på innehållet. Anledningen är att engagemang inte är en tillförlitlig kvalitetsindikator när få personer har exponerats för en vara. I dessa fall, engagemang genererar en brusig signal, och algoritmen kommer sannolikt att förstärka detta initiala brus. När väl populariteten för ett föremål av låg kvalitet är tillräckligt stor, det kommer att fortsätta att förstärkas.

Algoritmer är inte det enda som påverkas av engagemangsbias – det kan också påverka människor. Bevis visar att information överförs via "komplex smitta, "det betyder ju fler gånger människor exponeras för en idé online, desto mer sannolikt är det att de adopterar och delar det vidare. När sociala medier berättar att ett föremål blir viralt, deras kognitiva fördomar slår in och översätts till den oemotståndliga driften att uppmärksamma det och dela det.

Inte så kloka folkmassor

Vi körde nyligen ett experiment med en app för nyhetsläserhet som heter Fakey. Det är ett spel utvecklat av vårt labb, som simulerar ett nyhetsflöde som Facebook och Twitter. Spelare ser en blandning av aktuella artiklar från falska nyheter, skräpvetenskap, hyperpartiska och konspiratoriska källor, såväl som vanliga källor. De får poäng för att dela eller gilla nyheter från pålitliga källor och för att flagga artiklar med låg trovärdighet för faktakontroll.

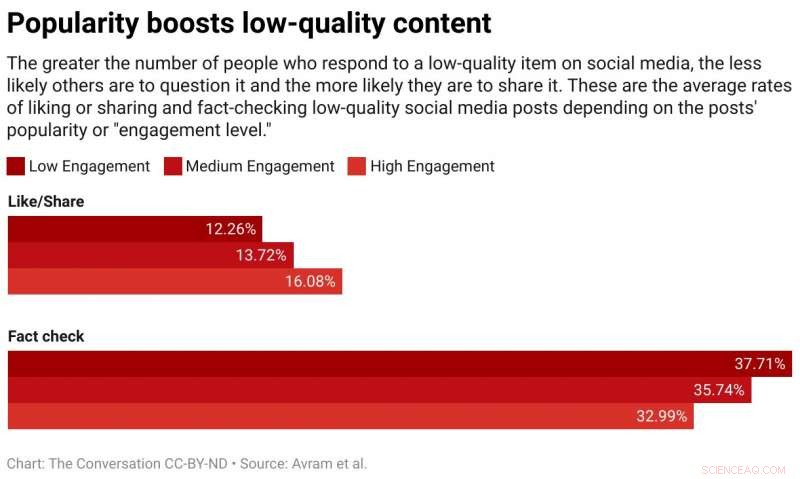

Vi fann att spelare är mer benägna att gilla eller dela och mindre benägna att flagga artiklar från källor med låg trovärdighet när spelare kan se att många andra användare har engagerat sig i dessa artiklar. Exponering för engagemangsmåtten skapar alltså en sårbarhet.

Folkmassornas visdom misslyckas eftersom den bygger på det falska antagandet att folkmassan består av olika, oberoende källor. Det kan finnas flera anledningar till att så inte är fallet.

Först, på grund av människors tendens att umgås med liknande människor, deras onlinekvarter är inte särskilt olika. Lättheten med vilken användare av sociala medier kan bli vän med dem som de inte håller med om driver människor in i homogena samhällen, kallas ofta ekokammare.

Andra, eftersom många människors vänner är vänner till varandra, de påverkar varandra. Ett känt experiment visade att att veta vilken musik dina vänner gillar påverkar dina egna uttalade preferenser. Din sociala önskan att anpassa sig förvränger ditt oberoende omdöme.

Tredje, popularitetssignaler kan spelas. Över åren, sökmotorer har utvecklat sofistikerade tekniker för att motverka så kallade "länkfarmar" och andra system för att manipulera sökalgoritmer. Sociala medieplattformar, å andra sidan, har precis börjat lära sig om sina egna sårbarheter.

Människor som syftar till att manipulera informationsmarknaden har skapat falska konton, som troll och sociala bots, och organiserade falska nätverk. De har översvämmat nätverket för att skapa sken av att en konspirationsteori eller en politisk kandidat är populär, lura både plattformsalgoritmer och människors kognitiva fördomar på en gång. De har till och med ändrat strukturen på sociala nätverk för att skapa illusioner om majoritetens åsikter.

Ringa ned engagemang

Vad ska man göra? Teknikplattformar är för närvarande på defensiven. De blir mer aggressiva under valen när det gäller att ta bort falska konton och skadlig desinformation. Men dessa ansträngningar kan vara besläktade med en omgång mullvad.

En annorlunda, ett förebyggande tillvägagångssätt skulle vara att lägga till friktion. Med andra ord, för att bromsa processen att sprida information. Högfrekventa beteenden som automatiserad gillande och delning kan hämmas av CAPTCHA-tester eller avgifter. Detta skulle inte bara minska möjligheterna till manipulation, men med mindre information skulle människor kunna ägna mer uppmärksamhet åt vad de ser. Det skulle lämna mindre utrymme för engagemangsbias att påverka människors beslut.

Det skulle också hjälpa om sociala medieföretag justerade sina algoritmer för att förlita sig mindre på engagemang för att avgöra vilket innehåll de tjänar dig. Kanske kommer avslöjandena av Facebooks kunskap om trollfarmar som utnyttjar engagemang ge den nödvändiga drivkraften.

Denna artikel publiceras från The Conversation under en Creative Commons -licens. Läs originalartikeln.