Kredit:Queensland University of Technology

Robotiker på QUT har utvecklat ett snabbare och mer exakt sätt för robotar att greppa föremål, inklusive i röriga och föränderliga miljöer, som har potential att förbättra deras användbarhet i både industriella och hemliga miljöer.

QUT:s Dr Jürgen Leitner sa att det var en grundläggande uppgift för människor att greppa och plocka upp ett föremål. det hade visat sig vara otroligt svårt för maskiner.

"Vi har kunnat programmera robotar, i mycket kontrollerade miljöer, att plocka upp mycket specifika föremål. Dock, en av de viktigaste bristerna med nuvarande robotgreppsystem är oförmågan att snabbt anpassa sig till förändringar, som när ett föremål flyttas, " sa Dr Leitner.

"Världen är inte förutsägbar – saker förändras och rör sig och blandas ihop och, ofta, som sker utan förvarning – så robotar måste kunna anpassa sig och arbeta i mycket ostrukturerade miljöer om vi vill att de ska vara effektiva, " han sa.

Den nya metoden, utvecklad av Ph.D. forskaren Douglas Morrison, Dr Leitner och den framstående professor Peter Corke från QUT:s naturvetenskapliga fakultet, är en realtid, objektoberoende greppsyntesmetod för gripande i slutna slinga.

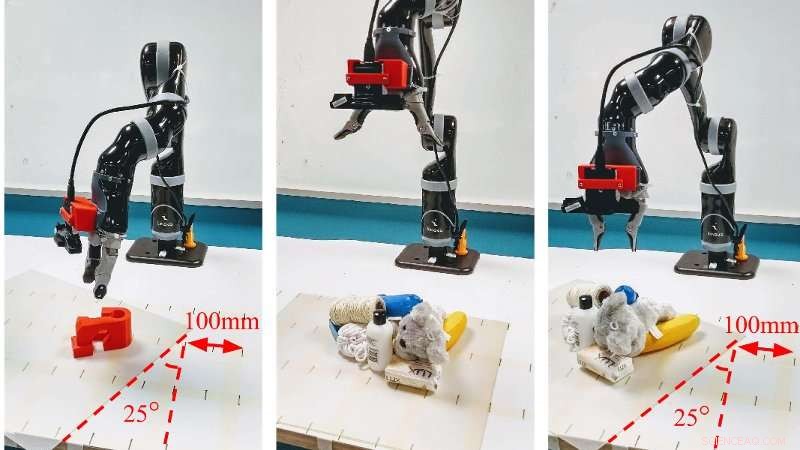

"Generative Grasping Convolutional Neural Network-metoden fungerar genom att förutsäga kvaliteten och posituren för ett tvåfingrat grepp vid varje pixel. Genom att kartlägga vad som finns framför den med hjälp av en djupbild i ett enda pass, roboten behöver inte prova många olika möjliga grepp innan de fattar ett beslut, undvika långa beräkningstider, " sa Mr Morrison.

"I våra verkliga tester, vi uppnådde en 83 % framgångsfrekvens för grepp på en uppsättning tidigare osynliga objekt med motstridig geometri och 88 % på en uppsättning hushållsobjekt som flyttades under greppförsöket. Vi uppnår också 81 % noggrannhet när vi greppar i dynamisk röran."

Dr Leitner sa att tillvägagångssättet övervann ett antal begränsningar hos nuvarande djupinlärningstekniker.

"Till exempel, i Amazon Picking Challenge, som vårt lag vann 2017, vår robot CartMan skulle titta in i en behållare med föremål, ta ett beslut om var det bästa stället var att greppa ett föremål och gå sedan blint in för att försöka plocka upp det, " han sa

"Med den här nya metoden, vi kan bearbeta bilder av objekten som en robot ser inom cirka 20 millisekunder, vilket gör att roboten kan uppdatera sitt beslut om var den ska greppa ett föremål och sedan göra det med mycket större syfte. Detta är särskilt viktigt i röriga utrymmen, " han sa.

Kredit:Queensland University of Technology

Dr Leitner sa att förbättringarna skulle vara värdefulla för industriell automation och i hemmiljöer.

"Denna forskningslinje gör det möjligt för oss att använda robotsystem inte bara i strukturerade miljöer där hela fabriken är byggd utifrån robotkapacitet. Den tillåter oss också att greppa objekt i ostrukturerade miljöer, där saker och ting inte är perfekt planerade och ordnade, och robotar måste anpassa sig till förändringar.

"Detta har fördelar för industrin – från lager för onlineshopping och sortering, till fruktplockning. Det kan även användas i hemmet, eftersom mer intelligenta robotar utvecklas för att inte bara dammsuga eller moppa ett golv, men också att plocka upp saker och lägga undan dem."

Teamets tidning Closing the Loop for Robotic Grasping:A Real-time, Generative Grasp Synthesis Approach kommer att presenteras denna vecka på Robotics:Science and Systems, den mest selektiva internationella robotkonferensen, som hålls på Carnegie Mellon University i Pittsburgh USA.