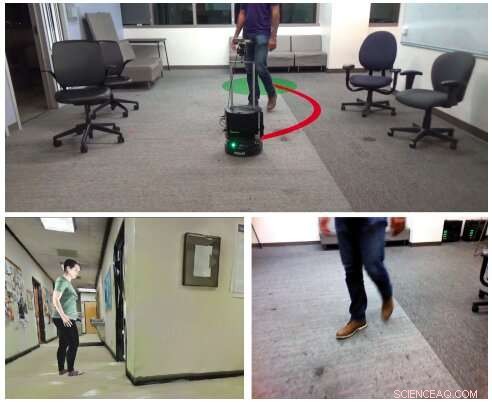

(Överst) Ett autonomt visuellt navigationsscenario som forskarna överväger, i en tidigare okänd, inomhusmiljö med människor, med monokulära RGB -bilder (längst ner till höger). För att lära maskiner hur man navigerar inomhusmiljöer som innehåller människor, forskarna skapade HumANav, en dataset som möjliggör fotorealistisk återgivning i simulerade miljöer (t.ex. längst ner till vänster). Upphovsman:Tolani et al.

För att hantera de uppgifter som de är utformade för att slutföra, mobilrobotar ska kunna navigera i verkliga miljöer effektivt, undvika människor eller andra hinder i sin omgivning. Även om statiska objekt vanligtvis är ganska enkla för robotar att upptäcka och kringgå, att undvika människor kan vara mer utmanande, eftersom det innebär att förutsäga deras framtida rörelser och planera därefter.

Forskare vid University of California, Berkeley, har nyligen utvecklat ett nytt ramverk som kan förbättra robotnavigering bland människor i inomhusmiljöer som kontor, hem eller museer. Deras modell, presenterad i ett papper som för publicerats på arXiv, utbildades i en ny sammanställd dataset av fotorealistiska bilder som heter HumANav.

"Vi föreslår en ny ram för navigering runt människor som kombinerar inlärningsbaserad uppfattning med modellbaserad optimal kontroll, "skrev forskarna i sin artikel.

Den nya ram som dessa forskare utvecklade, kallad LB-WayPtNav-DH, har tre nyckelkomponenter:en uppfattning, en planering, och en kontrollmodul. Perceptionsmodulen är baserad på ett konvolutionellt neuralt nätverk (CNN) som utbildades för att kartlägga robotens visuella ingång till en waypoint (dvs. nästa önskade tillstånd) med hjälp av övervakat lärande.

Den waypoint som kartläggs av CNN matas sedan till ramens planerings- och kontrollmoduler. Kombinerad, dessa två moduler säkerställer att roboten flyttar till sin målplats på ett säkert sätt, undvika hinder och människor i omgivningen.

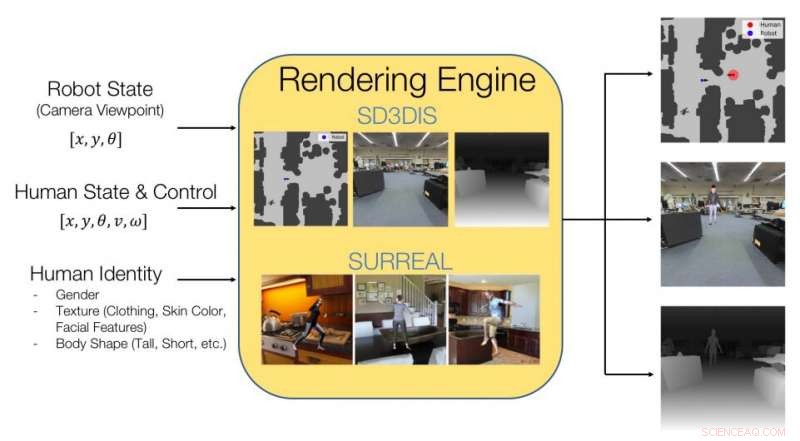

Bild som förklarar vad HumANav -datamängden innehåller och hur den uppnår fotorealistisk återgivning av inomhusmiljöer som innehåller människor. Upphovsman:Tolani et al.

Forskarna utbildade sitt CNN i bilder som ingår i en datamängd som de sammanställt, kallad HumANav. HumANav innehåller fotorealistiska, återgivna bilder av simulerade byggnadsmiljöer där människor rör sig, anpassad från en annan dataset som heter SURREAL. Dessa bilder skildrar 6000 promenader, strukturerade mänskliga maskor, arrangerad efter kroppsform, kön och hastighet.

"Det föreslagna ramverket lär sig att förutse och reagera på människors rörelse endast baserat på en monokulär RGB -bild, utan att uttryckligen förutsäga framtida mänsklig rörelse, "skrev forskarna i sin artikel.

Forskarna utvärderade LB-WayPtNav-DH i en serie experiment, både i simuleringar och i den verkliga världen. I verkliga experiment, de applicerade det på Turtlebot 2, en billig mobilrobot med programvara med öppen källkod. Forskarna rapporterar att robotnavigeringsramen generaliserar väl till osynliga byggnader, effektivt kringgå människor både i simulerade och verkliga miljöer.

"Våra experiment visar att kombination av modellbaserad kontroll och inlärning leder till bättre och mer dataeffektivt navigationsbeteende jämfört med ett rent inlärningsbaserat tillvägagångssätt, "skrev forskarna i sin artikel.

Det nya ramverket kan i slutändan tillämpas på en mängd olika mobila robotar, förbättra deras navigering i inomhusmiljöer. Än så länge, deras tillvägagångssätt har visat sig fungera anmärkningsvärt bra, överföra policyer som utvecklats i simulering till verkliga miljöer.

I deras framtida studier, forskarna planerar att träna sina ramar på bilder av mer komplexa eller trånga miljöer. Dessutom, de skulle vilja bredda utbildningsdataset som de sammanställt, inklusive en mer mångsidig uppsättning bilder.

© 2020 Science X Network