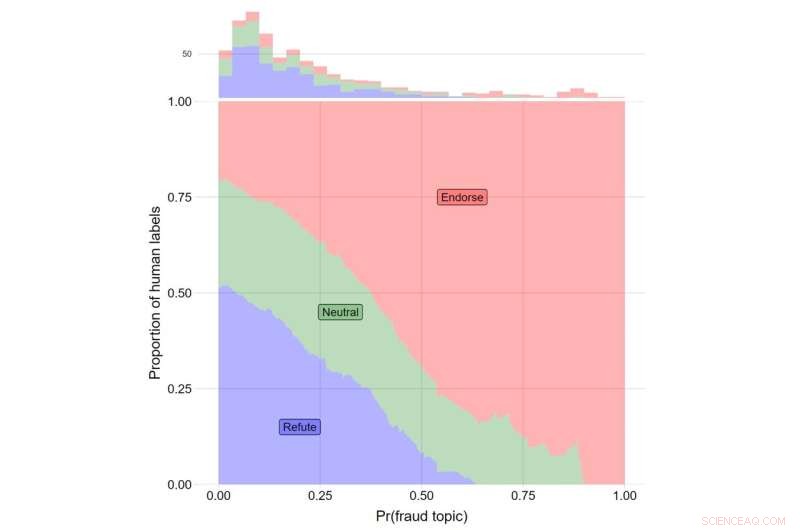

Y-axeln indikerar andelen mänskliga etiketter för videor som motbevisar Trumps påståenden (i blått), de som rapporterar om Trumps påståenden neutralt (grönt) och de som stöder Trumps påståenden (röd). X-axeln indikerar θ-värdet för ämne #108. Det totala antalet videor som faller inom varje kategori indikeras med histogrammet längst upp i handlingen. Kredit:Journal of Online Trust and Safety (2022). https://doi.org/10.54501/jots.v1i3.60

YouTube var mer benägna att rekommendera videor om valfusk till användare som redan var skeptiska till legitimiteten av det amerikanska presidentvalet 2020, visar en ny studie som undersöker effekten av sajtens algoritmer.

Resultaten av forskningen, som publiceras i Journal of Online Trust and Safety , visade att de som var mest skeptiska till valets legitimitet visades tre gånger så många valbedrägerirelaterade videor som de minst skeptiska deltagarna – ungefär 8 ytterligare rekommendationer av cirka 400 videor som föreslogs till varje studiedeltagare.

Även om den övergripande förekomsten av dessa typer av videor var låg, avslöjar resultaten konsekvenserna av ett rekommendationssystem som ger användarna det innehåll de vill ha. För dem som är mest bekymrade över eventuella valfusk, var att visa dem relaterat innehåll en mekanism genom vilken desinformation, desinformation och konspirationer kan hitta vägen till dem som mest sannolikt tror dem, observera författarna till studien. Viktigt är att dessa mönster återspeglar algoritmens oberoende inflytande på vilka verkliga användare som visas när de använder plattformen.

"Våra resultat avslöjar de skadliga konsekvenserna av rekommendationsalgoritmer och ställer tvivel om uppfattningen att onlineinformationsmiljöer enbart bestäms av användarnas val", säger James Bisbee, som ledde studien som postdoktor vid New York Universitys Center for Social Media and Politics (CSMaP).

Nästan två år efter presidentvalet 2020 tror ett stort antal amerikaner, särskilt republikaner, inte på legitimiteten i resultatet.

"Ungefär 70% av republikanerna ser inte Biden som den legitima vinnaren", trots "flera omräkningar och granskningar som bekräftade Joe Bidens vinst", skrev Poynter Institutes PolitiFact tidigare i år.

Även om det är välkänt att sociala medieplattformar, som YouTube, riktar innehåll till användare baserat på deras sökpreferenser, kanske konsekvenserna av denna dynamik inte är helt insedda.

I CSMaP-studien tog forskarna ett urval av mer än 300 amerikaner med YouTube-konton i november och december 2020. Försökspersonerna tillfrågades hur bekymrade de var över ett antal aspekter av valfusk, inklusive falska röstsedlar som räknas, giltiga röstsedlar kasseras, utländska regeringar som blandar sig och icke-amerikanska medborgare som röstar, bland andra frågor.

Dessa deltagare ombads sedan att installera ett webbläsartillägg som skulle registrera listan med rekommendationer som de visades. Försökspersonerna instruerades sedan att klicka på en slumpmässigt tilldelad YouTube-video ("frövideon") och sedan klicka på en av rekommendationerna som de visades enligt en slumpmässigt tilldelad "genomgångsregel". Till exempel skulle användare som tilldelats den "andra genomgångsregeln" alltid behöva klicka på den andra videon i listan med rekommendationer som visas, oavsett innehållet. By restricting user behavior in these ways, the researchers were able to isolate the recommendation algorithm's influence on what real users were being suggested in real time.

The subjects then proceeded through a sequence of YouTube recommended videos, allowing the researchers to observe what the YouTube algorithm suggested to its users. Bisbee and his colleagues then compared the number of videos about election fraud in the 2020 U.S. presidential election that were recommended to participants who were more skeptical about the legitimacy of the election to those recommended to participants who were less skeptical. These results showed that election skeptics were recommended an average of eight additional videos about possible fraud in the 2020 US election, relative to non-skeptical participants (12 vs. 4).

"Many believe that automated recommendation algorithms have little influence on online 'echo chambers' in which users only see content that reaffirms their preexisting views," observes Bisbee, now an assistant professor at Vanderbilt University.

"Our study, however, suggests that YouTube's recommendation algorithm was able to determine which users were more likely to be concerned about fraud in the 2020 U.S. presidential election and then suggested up to three times as many videos about election fraud to these users compared to those less concerned about election fraud. This highlights the need for further investigation into how opaque recommendation algorithms operate on an issue-by-issue basis." + Utforska vidare