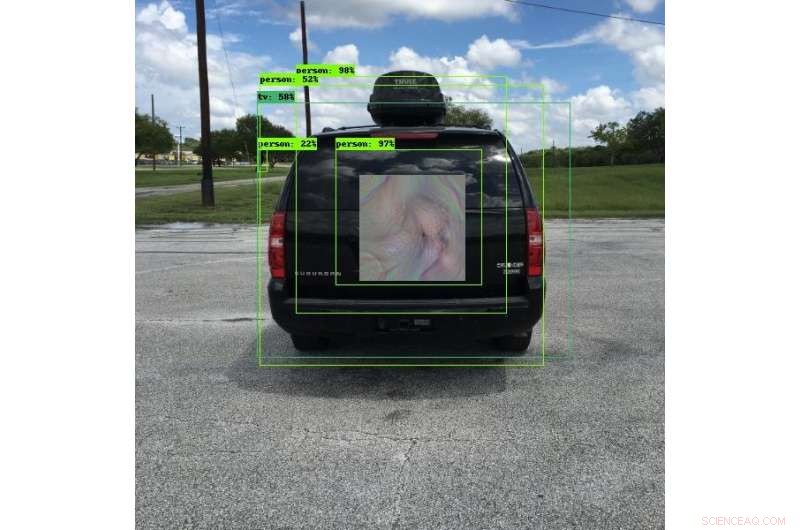

Många av dagens fordon använder objektdetekteringssystem för att undvika kollisioner. SwRI-ingenjörer utvecklade unika mönster som kan lura dessa system att se något annat, att se föremålen på en annan plats eller inte se föremålen alls. På det här fotot, objektdetekteringssystemet ser en person snarare än ett fordon. Denna forskning kommer att tillåta ingenjörer att noggrant testa system för objektdetektering och förbättra säkerheten för de djupinlärningsalgoritmer de använder. Kredit:Southwest Research Institute

Nya motstridiga tekniker utvecklade av ingenjörer vid Southwest Research Institute kan göra objekt "osynliga" för bilddetekteringssystem som använder algoritmer för djupinlärning. Dessa tekniker kan också lura system att tro att de ser ett annat objekt eller kan ändra platsen för objekt. Tekniken minskar risken för kompromisser i automatiserade bildbehandlingssystem.

"Deep-learning neurala nätverk är mycket effektiva vid många uppgifter, " säger forskningsingenjör Abe Garza från SwRI Intelligent Systems Division. "Men, djupinlärning antogs så snabbt att säkerhetskonsekvenserna av dessa algoritmer inte övervägdes fullt ut."

Algoritmer för djupinlärning utmärker sig i att använda former och färg för att känna igen skillnaderna mellan människor och djur eller bilar och lastbilar, till exempel. Dessa system upptäcker på ett tillförlitligt sätt objekt under en rad förhållanden och, som sådan, används i otaliga applikationer och industrier, ofta för säkerhetskritiska ändamål. Bilindustrin använder system för djupinlärning av objektdetektering på vägar för körfältsassistans, teknik för körfältsavvikelse och kollisionsundvikande. Dessa fordon är beroende av kameror för att upptäcka potentiellt farliga föremål runt dem. Medan bildbehandlingssystemen är avgörande för att skydda liv och egendom, Algoritmerna kan luras av parter som är avsedda att orsaka skada.

Säkerhetsforskare som arbetar med "adversarial learning" hittar och dokumenterar sårbarheter i djup- och andra maskininlärningsalgoritmer. Genom att använda SwRI interna forskningsmedel, Garza och senior forskningsingenjör David Chambers utvecklade vad som ser ut som futuristiskt, Mönster i bohemisk stil. När den bärs av en person eller monteras på ett fordon, mönstren lurar kameror för att detektera föremål att tro att föremålen inte finns där, att de är något annat eller att de är på en annan plats. Skadliga parter kan placera dessa mönster nära vägar, potentiellt skapa kaos för fordon utrustade med objektdetektorer.

Det som ser ut som ett färgglatt mönster för det mänskliga ögat ser ut som en cykel till ett objektdetekteringssystem. Även om djupinlärningsalgoritmer som används i dessa system är tillförlitliga, de kan luras med speciella bilder. SwRI-forskare utvecklar tekniker för att minska risken för kompromisser i dessa system. Kredit:Southwest Research Institute

"Dessa mönster gör att algoritmerna i kameran antingen felklassificerar eller fellokaliserar objekt, skapa en sårbarhet, ", sa Garza. "Vi kallar dessa mönster 'perception oföränderliga' motstridiga exempel eftersom de inte behöver täcka hela objektet eller vara parallella med kameran för att lura algoritmen. Algoritmerna kan felklassificera objektet så länge de känner av någon del av mönstret."

Även om de kan se ut som unika och färgglada konstutställningar för det mänskliga ögat, dessa mönster är utformade på ett sådant sätt att kamerasystem för objektdetektering ser dem mycket specifikt. Ett mönster förklädd som en reklam på baksidan av en stannad buss kan få ett system för att undvika kollisioner att tro att det ser en ofarlig shoppingväska istället för bussen. Om fordonets kamera inte kan upptäcka det verkliga föremålet, den kunde fortsätta röra sig framåt och träffa bussen, orsakar en potentiellt allvarlig kollision.

"Första steget för att lösa dessa missbruk är att testa algoritmerna för djupinlärning, " sa Garza. Teamet har skapat ett ramverk som kan testa dessa attacker upprepade gånger mot en mängd olika djupinlärningsprogram, vilket kommer att vara extremt användbart för att testa lösningar.

SwRI-forskare fortsätter att utvärdera hur mycket, eller hur lite, av mönstret behövs för att felklassificera eller felplacera ett objekt. Arbeta med kunder, denna forskning kommer att göra det möjligt för teamet att testa system för objektdetektering och i slutändan förbättra säkerheten för algoritmer för djupinlärning.